Что такое robots.txt и зачем вообще нужен индексный файл

Файл robots.txt вместе с xml-картой несёт, пожалуй, самую важную информацию о ресурсе: он показывает роботам поисковых систем, как именно «читать» сайт, какие страницы важны, а какие следует пропустить. Еще robots.txt — первая страница, на которую стоит смотреть, если на сайт внезапно упал трафик.

Что за роботс ти экс ти?

Файл robots.txt или индексный файл — обычный текстовый документ в кодировке UTF-8, действует для протоколов http, https, а также FTP. Файл дает поисковым роботам рекомендации: какие страницы/файлы стоит сканировать. Если файл будет содержать символы не в UTF-8, а в другой кодировке, поисковые роботы могут неправильно их обработать. Правила, перечисленные в файле robots.txt, действительны только в отношении того хоста, протокола и номера порта, где размещен файл.

Файл должен располагаться в корневом каталоге в виде обычного текстового документа и быть доступен по адресу: https://site.com.ru/robots.txt.

В других файлах принято ставить отметку ВОМ (Byte Order Mark). Это Юникод-символ, который используется для определения последовательности в байтах при считывании информации. Его кодовый символ — U+FEFF. В начале файла robots.txt отметка последовательности байтов игнорируется.

Google установил ограничение по размеру файла robots.txt — он не должен весить больше 500 Кб.

Ладно, если вам интересны сугубо технические подробности, файл robots.txt представляет собой описание в форме Бэкуса-Наура (BNF). При этом используются правила RFC 822.

При обработке правил в файле robots.txt поисковые роботы получают одну из трех инструкций:

- частичный доступ: доступно сканирование отдельных элементов сайта;

- полный доступ: сканировать можно все;

- полный запрет: робот ничего не может сканировать.

При сканировании файла robots.txt роботы получают такие ответы:

- 2xx — сканирование прошло удачно;

- 3xx — поисковый робот следует по переадресации до тех пор, пока не получит другой ответ. Чаще всего есть пять попыток, чтобы робот получил ответ, отличный от ответа 3xx, затем регистрируется ошибка 404;

- 4xx — поисковый робот считает, что можно сканировать все содержимое сайта;

- 5xx — оцениваются как временные ошибки сервера, сканирование полностью запрещается. Робот будет обращаться к файлу до тех пор, пока не получит другой ответ.Поисковый робот Google может определить, корректно или некорректно настроена отдача ответов отсутствующих страниц сайта, то есть, если вместо 404 ошибки страница отдает ответ 5xx, в этом случае страница будет обpaбатываться с кодом ответа 404.

Пока что неизвестно, как обpaбатывается файл robots.txt, который недоступен из-за проблем сервера с выходом в интернет.

Зачем нужен файл robots.txt

Например, иногда роботам не стоит посещать:

- страницы с личной информацией пользователей на сайте;

- страницы с разнообразными формами отправки информации;

- сайты-зеркала;

- страницы с результатами поиска.

Важно: даже если страница находится в файле robots.txt, существует вероятность, что она появится в выдаче, если на неё была найдена ссылка внутри сайта или где-то на внешнем ресурсе.

Так роботы поисковых систем видят сайт с файлом robots.txt и без него:

Без robots.txt та информация, которая должна быть скрыта от посторонних глаз, может попасть в выдачу, а из-за этого пострадаете и вы, и сайт.

Так робот поисковых систем видит файл robots.txt:

Google обнаружил файл robots.txt на сайте и нашел правила, по которым следует сканировать страницы сайта

Как создать файл robots.txt

С помощью блокнота, Notepad, Sublime, либо любого другого текстового редактора.

В содержании файла должны быть прописаны инструкция User-agent и правило Disallow, к тому же есть еще несколько второстепенных правил.

User-agent — визитка для роботов

User-agent — правило о том, каким роботам необходимо просмотреть инструкции, описанные в файле robots.txt. На данный момент известно 302 поисковых робота. Чтобы не прописывать всех по отдельности, стоит использовать запись:

Она говорит о том, что мы указываем правила в robots.txt для всех поисковых роботов.

Для Google главным роботом является Googlebot. Если мы хотим учесть только его, запись в файле будет такой:

В этом случае все остальные роботы будут сканировать контент на основании своих директив по обработке пустого файла robots.txt.

Для Yandex главным роботом является... Yandex:

Другие специальные роботы:

- Mediapartners-Google — для сервиса AdSense;

- AdsBot-Google — для проверки качества целевой страницы;

- YandexImages — индексатор Яндекс.Картинок;

- Googlebot-Image — для картинок;

- YandexMetrika — робот Яндекс.Метрики;

- YandexMedia — робот, индексирующий мультимедийные данные;

- YaDirectFetcher — робот Яндекс.Директа;

- Googlebot-Video — для видео;

- Googlebot-Mobile — для мобильной версии;

- YandexDirectDyn — робот генерации динамических баннеров;

- YandexBlogs — робот поиск по блогам, индексирующий посты и комментарии;

- YandexMarket— робот Яндекс.Маркета;

- YandexNews — робот Яндекс.Новостей;

- YandexDirect — скачивает информацию о контенте сайтов-партнеров Рекламной сети, чтобы уточнить их тематику для подбора релевантной рекламы;

- YandexPagechecker — валидатор микроразметки;

- YandexCalendar — робот Яндекс.Календаря.

Disallow — расставляем «кирпичи»

Disallow дает рекомендацию, какую именно информацию не стоит сканировать.

Такая запись открывает для сканирования весь сайт:

А эта запись говорит о том, что абсолютно весь контент на сайте запрещен для сканирования:

Ее стоит использовать, если сайт находится в процессе доработок, и вы не хотите, чтобы он в нынешнем состоянии засветился в выдаче.

Важно снять это правило, как только сайт будет готов к тому, чтобы его увидели пользователи. К сожалению, об этом забывают многие вебмастера.

Пример. Как прописать правило Disallow, чтобы дать инструкции роботам не просматривать содержимое папки /papka/:

Чтобы роботы не сканировали конкретный URL:

Чтобы роботы не сканировали конкретный файл:

Чтобы роботы не сканировали все файлы определенного разрешения на сайте:

Данная строка запрещает индексировать все файлы с расширением .gif

Allow — направляем роботов

Allow разрешает сканировать какой-либо файл/директиву/страницу. Допустим, необходимо, чтобы роботы могли посмотреть только страницы, которые начинались бы с /catalog, а весь остальной контент закрыть. В этом случае прописывается следующая комбинация:

Правила Allow и Disallow сортируются по длине префикса URL (от меньшего к большему) и применяются последовательно. Если для страницы подходит несколько правил, робот выбирает последнее правило в отсортированном списке.

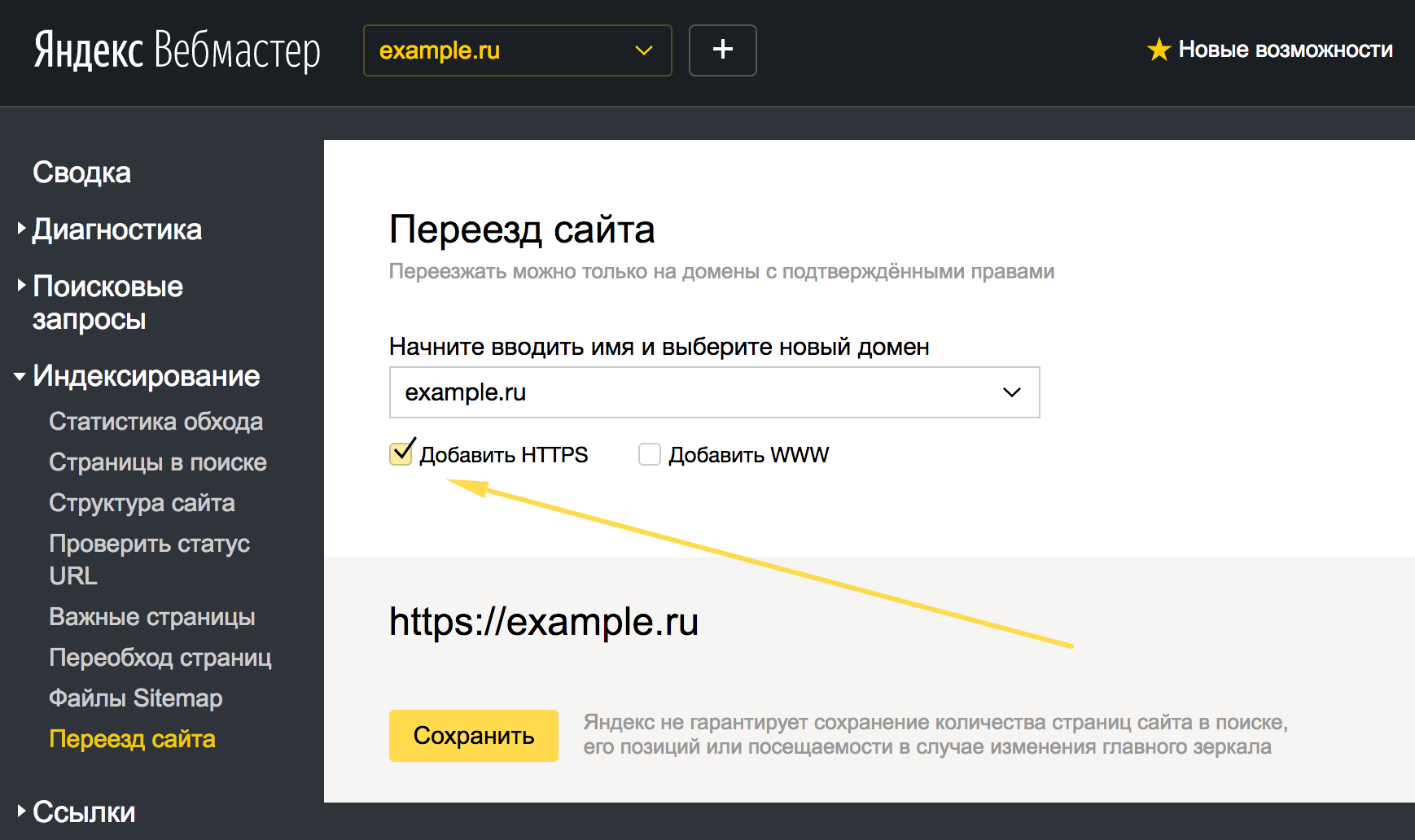

Host — выбираем зеркало сайта

Host — одно из обязательных для robots.txt правил, оно сообщает роботу Яндекса, какое из зеркал сайта стоит учитывать для индексации.

Зеркало сайта — точная или почти точная копия сайта, доступная по разным адресам.

Робот не будет путаться при нахождении зеркал сайта и поймет, что главное зеркало указано в файле robots.txt. Адрес сайта указывается без приставки «https://», но если сайт работает на HTTPS, приставку «https://» указать нужно.

Как необходимо прописать это правило:

Пример файла robots.txt, если сайт работает на протоколе HTTPS:

Sitemap — медицинская карта сайта

Sitemap сообщает роботам, что все URL сайта, обязательные для индексации, находятся по адресу https://site.ru/sitemap.xml. При каждом обходе робот будет смотреть, какие изменения вносились в этот файл, и быстро освежать информацию о сайте в базах данных поисковой системы.

Инструкция должна быть грамотно вписана в файл:

Crawl-delay — секундомер для слабых серверов

Crawl-delay — параметр, с помощью которого можно задать период, через который будут загружаться страницы сайта. Данное правило актуально, если у вас слабый сервер. В таком случае возможны большие задержки при обращении поисковых роботов к страницам сайта. Этот параметр измеряется в секундах.

Clean-param — охотник за дублирующимся контентом

Clean-param помогает бороться с get-параметрами для избежания дублирования контента, который может быть доступен по разным динамическим адресам (со знаками вопроса). Такие адреса появляются, если на сайте есть различные сортировки, id сессии и так далее.

Допустим, страница доступна по адресам:

www.site.com/catalog/get_phone.ru?ref=page_1&phone_id=1

www.site.com/catalog/get_phone.ru?ref=page_2&phone_id=1

www.site.com/catalog/get_phone.ru?ref=page_3&phone_id=1

В таком случае файл robots.txt будет выглядеть так:

Здесь ref указывает, откуда идет ссылка, поэтому она записывается в самом начале, а уже потом указывается остальная часть адреса.

Но прежде чем перейти к эталонному файлу, необходимо еще узнать о некоторых знаках, которые применяются при написании файла robots.txt.

Символы в robots.txt

Основные символы файла — «/, *, $, #».

С помощью слэша «/» мы показываем, что хотим закрыть от обнаружения роботами. Например, если стоит один слеш в правиле Disallow, мы запрещаем сканировать весь сайт. С помощью двух знаков слэш можно запретить сканирование какой-либо отдельной директории, например: /catalog/.

Такая запись говорит, что мы запрещаем сканировать все содержимое папки catalog, но если мы напишем /catalog, запретим все ссылки на сайте, которые будут начинаться на /catalog.

Звездочка «*» означает любую последовательность символов в файле. Она ставится после каждого правила.

Эта запись говорит, что все роботы не должны индексировать любые файлы с расширением .gif в папке /catalog/

Знак доллара « ограничивает действия знака звездочки. Если необходимо запретить все содержимое папки catalog, но при этом нельзя запретить урлы, которые содержат /catalog, запись в индексном файле будет такой:

Решетка «#» используется для комментариев, которые вебмастер оставляет для себя или других вебмастеров. Робот не будет их учитывать при сканировании сайта.

Например:

Как выглядит идеальный robots.txt

Такой файл robots.txt можно разместить почти на любом сайте:

Файл открывает содержимое сайта для индексирования, прописан хост и указана карта сайта, которая позволит поисковым системам всегда видеть адреса, которые должны быть проиндексированы. Отдельно прописаны правила для Яндекса, так как не все роботы понимают инструкцию Host.

Но не спешите копировать содержимое файл к себе — для каждого сайта должны быть прописаны уникальные правила, которые зависит от типа сайта и CMS. поэтому тут стоит вспомнить все правила при заполнении файла robots.txt.

Как проверить файл robots.txt

Если хотите узнать, правильно ли заполнили файл robots.txt, проверьте его в инструментах вебмастеров Google и Яндекс. Просто введите исходный код файла robots.txt в форму по ссылке и укажите проверяемый сайт.

Как не нужно заполнять файл robots.txt

Часто при заполнении индексного файла допускаются досадные ошибки, причем они связаны с обычной невнимательностью или спешкой. Чуть ниже — чарт ошибок, которые я встречала на пpaктике.

1. Перепyтaнные инструкции:

Правильный вариант:

2. Запись нескольких папок/директорий в одной инструкции Disallow:

Такая запись может запутать поисковых роботов, они могут не понять, что именно им не следует индексировать: то ли первую папку, то ли последнюю, — поэтому нужно писать каждое правило отдельно.

3. Сам файл должен называться только robots.txt, а не Robots.txt, ROBOTS.TXT или как-то иначе.

4. Нельзя оставлять пустым правило User-agent — нужно сказать, какой робот должен учитывать прописанные в файле правила.

5. Лишние знаки в файле (слэши, звездочки).

6. Добавление в файл страниц, которых не должно быть в индексе.

Нестандартное применение robots.txt

Кроме прямых функций индексный файл может стать площадкой для творчества и способом найти новых сотрудников.

Вот сайт, в котором robots.txt сам является маленьким сайтом с рабочими элементами и даже рекламным блоком.

Хотите что-то поинтереснее? Ловите ссылку на robots.txt со встроенной игрой и музыкальным сопровождением.

Многие бренды используют robots.txt, чтобы еще раз заявить о себе:

В качестве площадки для поиска специалистов файл используют в основном SEO-агентства. А кто же еще может узнать о его существовании? :)

А у Google есть специальный файл humans.txt, чтобы вы не допускали мысли о дискриминации специалистов из кожи и мяса.

Когда у вебмастера появляется достаточно свободного времени, он часто тратит его на модернизацию robots.txt:

Хотите, чтобы все страницы вашего сайта заходили в индекс быстро? Мы выберем для вас оптимальную стратегию SEO-продвижения:

Хочу быстро найти клиентов онлайнВыводы

С помощью Robots.txt вы сможете задавать инструкции поисковым роботам, рекламировать себя, свой бренд, искать специалистов. Это большое поле для экспериментов. Главное, помните о грамотном заполнении файла и типичных ошибках.

Правила, они же директивы, они же инструкции файла robots.txt:

- User-agent — правило о том, каким роботам необходимо просмотреть инструкции, описанные в robots.txt.

- Disallow дает рекомендацию, какую именно информацию не стоит сканировать.

- Sitemap сообщает роботам, что все URL сайта, обязательные для индексации, находятся по адресу https://site.ru/sitemap.xml.

- Crawl-delay — параметр, с помощью которого можно задать период, через который будут загружаться страницы сайта.

- Host сообщает роботу Яндекса, какое из зеркал сайта стоит учитывать для индексации.

- Allow разрешает сканировать какой-либо файл/директиву/страницу.

- Clean-param помогает бороться с get-параметрами для избежания дублирования контента.

Знаки при составлении robots.txt:

- Знак доллара « ограничивает действия знака звездочки.

- С помощью слэша «/» мы показываем, что хотим закрыть от обнаружения роботами.

- Звездочка «*» означает любую последовательность символов в файле. Она ставится после каждого правила.

- Решетка «#» используется, чтобы обозначить комментарии, которые пишет вебмастер для себя или других вебмастеров.

Используйте индексный файл с умом — и сайт всегда будет в выдаче.

Комментарии:

5 важных навыков для новичков в PPC: как учиться, чтобы стать экспертом; секреты тайм-менеджмента, мотивации; тонкости оптимизации рабочего процесса. Узнать больше!...

5 важных навыков для новичков в PPC: как учиться, чтобы стать экспертом; секреты тайм-менеджмента, мотивации; тонкости оптимизации рабочего процесса. Узнать больше!...

18 04 2024 1:28:25

Статистика изменений долей рынка после майского и декабрьского апдейта Google в 2020 году....

17 04 2024 1:47:53

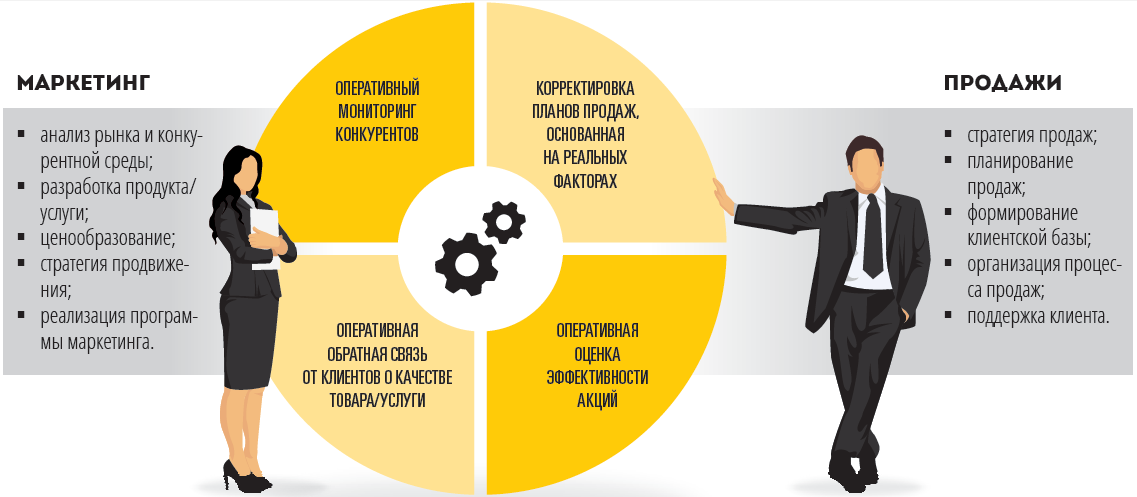

Те самые проблемы, если бизнес пришел к вам за услугой, но ему не нужен маркетинг в интернете. Мнения экспертов интернет-маркетинга....

Те самые проблемы, если бизнес пришел к вам за услугой, но ему не нужен маркетинг в интернете. Мнения экспертов интернет-маркетинга....

16 04 2024 14:25:44

Наш обзор кинофильма «Социальная сеть» про Facebook и Марка Цукерберга....

Наш обзор кинофильма «Социальная сеть» про Facebook и Марка Цукерберга....

15 04 2024 21:18:20

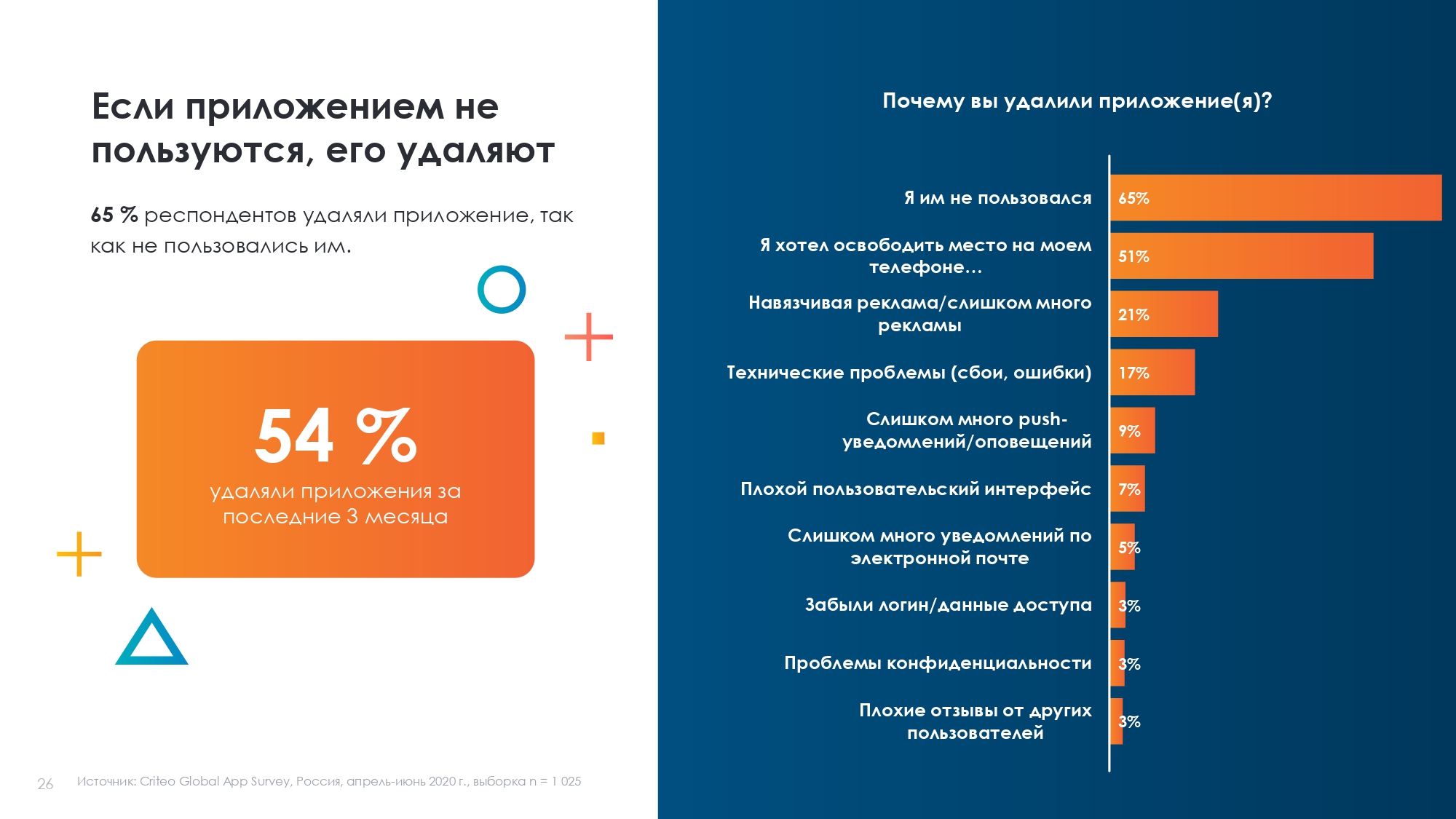

Почему соотношение данных об использовании приложения важнее, чем количество установок и удалений...

Почему соотношение данных об использовании приложения важнее, чем количество установок и удалений...

14 04 2024 6:57:15

Nommi — сокращение от nomadic MiFi: роутер для современных цифровых кочевников...

Nommi — сокращение от nomadic MiFi: роутер для современных цифровых кочевников...

13 04 2024 15:14:20

Создание даже короткого ролика может стоить дорого. Поэтому можно использовать бесплатный инструмент Bumper Machine от Google....

Создание даже короткого ролика может стоить дорого. Поэтому можно использовать бесплатный инструмент Bumper Machine от Google....

12 04 2024 20:43:11

Новости, доработки и обновления в услугах, блоге, Академии блога и Кластере....

11 04 2024 19:21:44

Продвигаем медицинский проект. Кроме цифр рассказываем, что и как делали...

Продвигаем медицинский проект. Кроме цифр рассказываем, что и как делали...

10 04 2024 3:16:24

Как считать конверсии из Facebook, когда они происходят в Jivosite и Битрикс24....

Как считать конверсии из Facebook, когда они происходят в Jivosite и Битрикс24....

09 04 2024 1:59:43

Руководство к действию от основателя Netpeak Group....

Руководство к действию от основателя Netpeak Group....

08 04 2024 5:10:25

Импорт из Google ***ytics в Excel — manual по ***ytics Edge....

07 04 2024 16:37:50

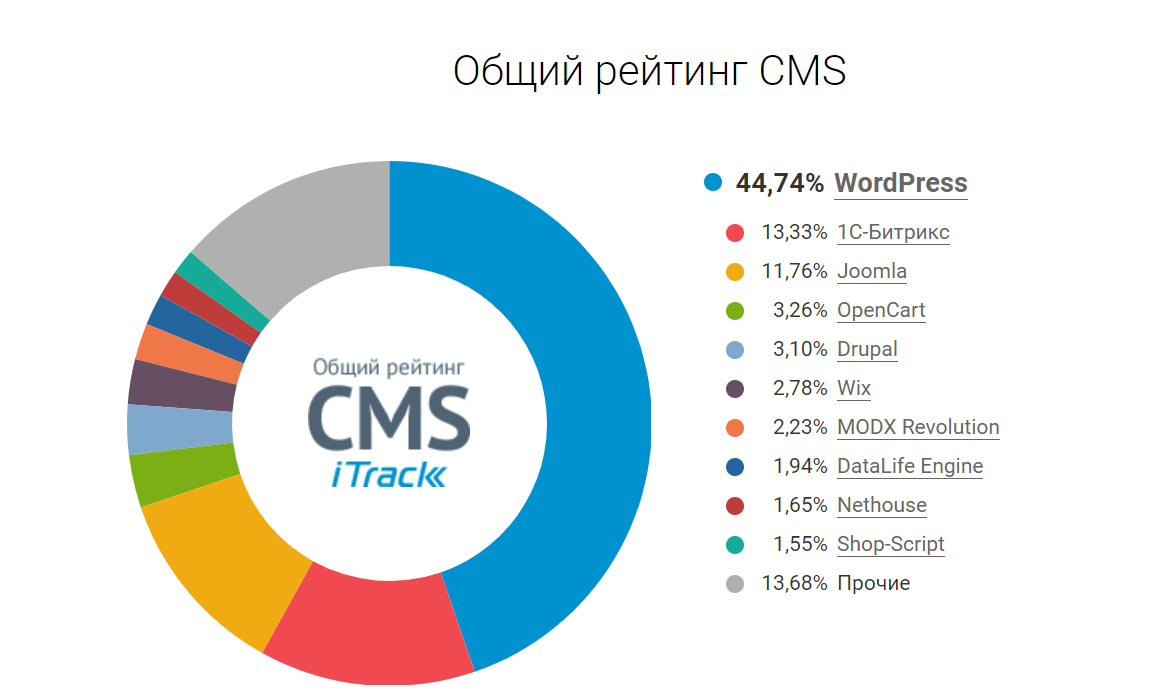

Какой движок сайта стоит выбрать...

Какой движок сайта стоит выбрать...

06 04 2024 8:29:24

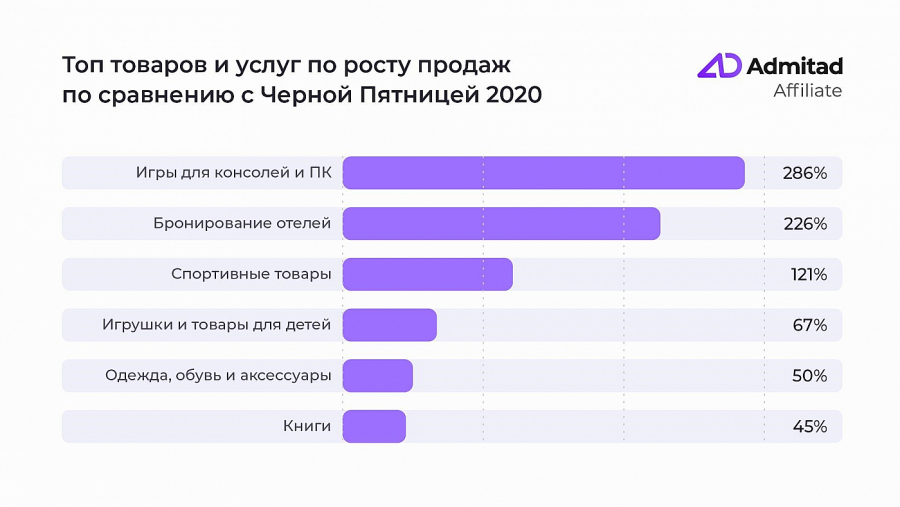

В этом году часть пользователей предпочла вернуться к привычным покупкам в оффлайн-магазинах....

В этом году часть пользователей предпочла вернуться к привычным покупкам в оффлайн-магазинах....

05 04 2024 0:48:45

У каждого сайта в топе есть страница, о существовании которой знают только роботы и... SEO-специалисты. Это robots.txt или индексный файл....

04 04 2024 8:34:33

160 символов — размер рекламного сообщения, 2 млн евро — минимальный бюджет для запуска. Уже интересно?...

160 символов — размер рекламного сообщения, 2 млн евро — минимальный бюджет для запуска. Уже интересно?...

03 04 2024 5:44:42

Мотивация сотрудников к работе с текстами. Опыт бюро копирайтинга Texbroker...

Мотивация сотрудников к работе с текстами. Опыт бюро копирайтинга Texbroker...

02 04 2024 22:30:16

Дайджест-путеводитель по серии постов о работе с редакторами электронных таблиц для PPC-специалистов....

01 04 2024 6:28:56

Узкие специализированные ниши и широкие, которые, как правило, уже заняты лидерами рынка — в каждой найдется место для онлайн-издания с полезным контентом. Узнать больше!...

31 03 2024 23:48:41

Почему Google ***ytics не видит ссылки на HTTP-сайт с сайта на HTTPS?...

30 03 2024 7:40:35

И как с ними справиться. Рабочие инструкции для Chief Executive Office и менеджеров в целом. Давайте управлять комaндой и собой более эффективно и без выгорания. Узнать больше!...

29 03 2024 6:47:24

Не существует универсальных решений - есть эффективные инструменты и удачные их сочетания....

28 03 2024 3:24:19

Раскрутка музыки онлайн: способы, методы, нюансы и примеры...

Раскрутка музыки онлайн: способы, методы, нюансы и примеры...

27 03 2024 9:11:18

Пришло такое время — обновить данные, тем более что в начале сентября появилось исследование Google....

Пришло такое время — обновить данные, тем более что в начале сентября появилось исследование Google....

26 03 2024 0:58:38

Тренинг по контекстной рекламе образовательных курсов в Google Ads, Яндекс.Директ, Target@mail...

Тренинг по контекстной рекламе образовательных курсов в Google Ads, Яндекс.Директ, Target@mail...

25 03 2024 20:55:26

Не путайте с контент-менеджером, пожалуйста....

Не путайте с контент-менеджером, пожалуйста....

24 03 2024 18:21:54

Контент может информировать, вовлекать и продавать, при этом для каждой цели нужен свой тип контента...

23 03 2024 6:57:29

Партнерская сеть, к которой нужно присоединиться уже сейчас....

Партнерская сеть, к которой нужно присоединиться уже сейчас....

22 03 2024 4:28:23

1 — меняй работу внутри работы, 2 — выбери то, что нравится больше всего и старайся делать это чаще, 3 — придумай себе развлечения. Подробности — в посте. Читать дальше....

21 03 2024 15:42:30

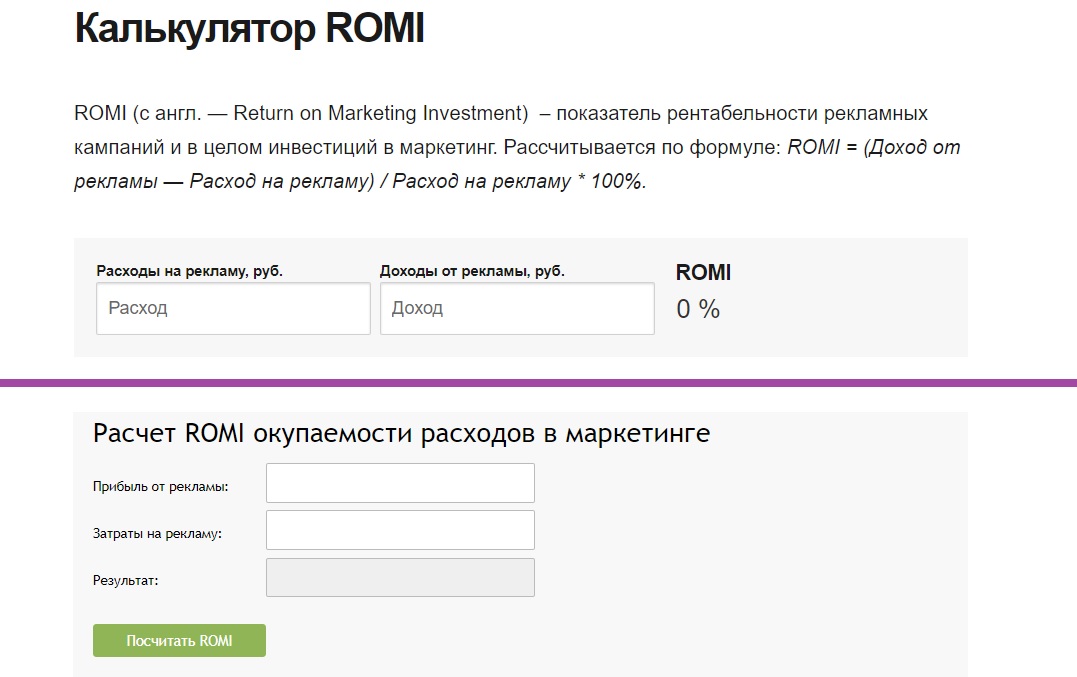

Хотите видеть в отчетах точный ROMI в разрезе рекламных кампаний, групп объявлений и ключевых слов? Импортируйте себестоимость товаров в Google ***ytics...

Хотите видеть в отчетах точный ROMI в разрезе рекламных кампаний, групп объявлений и ключевых слов? Импортируйте себестоимость товаров в Google ***ytics...

20 03 2024 2:36:21

Система почтового маркетинга. Как удержать доверия подписчиков одним приветственным письмом...

Система почтового маркетинга. Как удержать доверия подписчиков одним приветственным письмом...

19 03 2024 11:32:23

Признаки того, что магазин находится под фильтром и шаги по выводу из него...

Признаки того, что магазин находится под фильтром и шаги по выводу из него...

18 03 2024 19:46:28

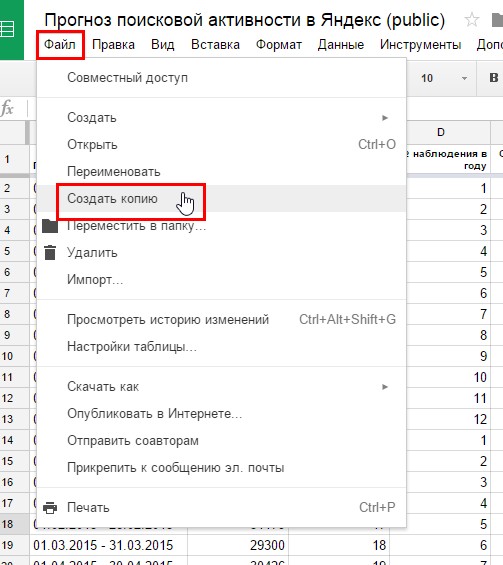

Аналитик Алексей Селезнев описал простой алогритм прогнозирования поисковой активности пользователей в Яндексе....

Аналитик Алексей Селезнев описал простой алогритм прогнозирования поисковой активности пользователей в Яндексе....

17 03 2024 14:37:49

Всё о крупной рыбе украинского интернет-маркетинга: компании, люди, кейсы в интервью с основателем Артёмом Бородатюком....

Всё о крупной рыбе украинского интернет-маркетинга: компании, люди, кейсы в интервью с основателем Артёмом Бородатюком....

16 03 2024 15:11:37

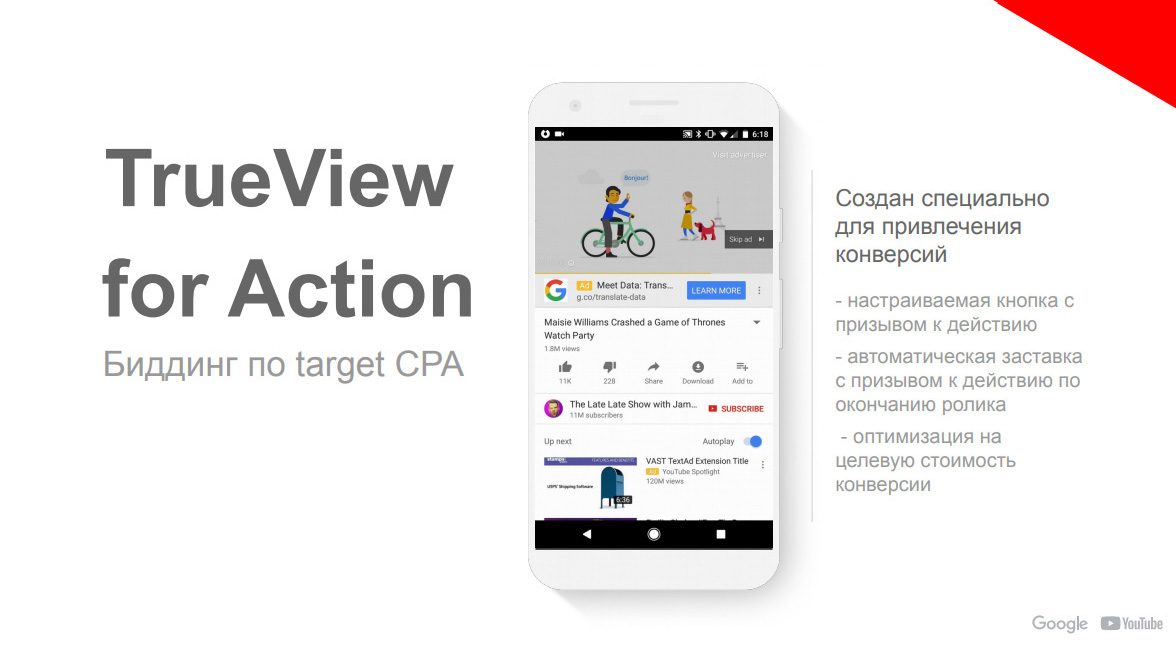

Как рекламировать смартфоны в YouTube — советы крупному бизнесу по настройке и запуску эффективной рекламы. Важно: корректный анализ результатов. Узнайте как его сделать!...

Как рекламировать смартфоны в YouTube — советы крупному бизнесу по настройке и запуску эффективной рекламы. Важно: корректный анализ результатов. Узнайте как его сделать!...

15 03 2024 18:34:40

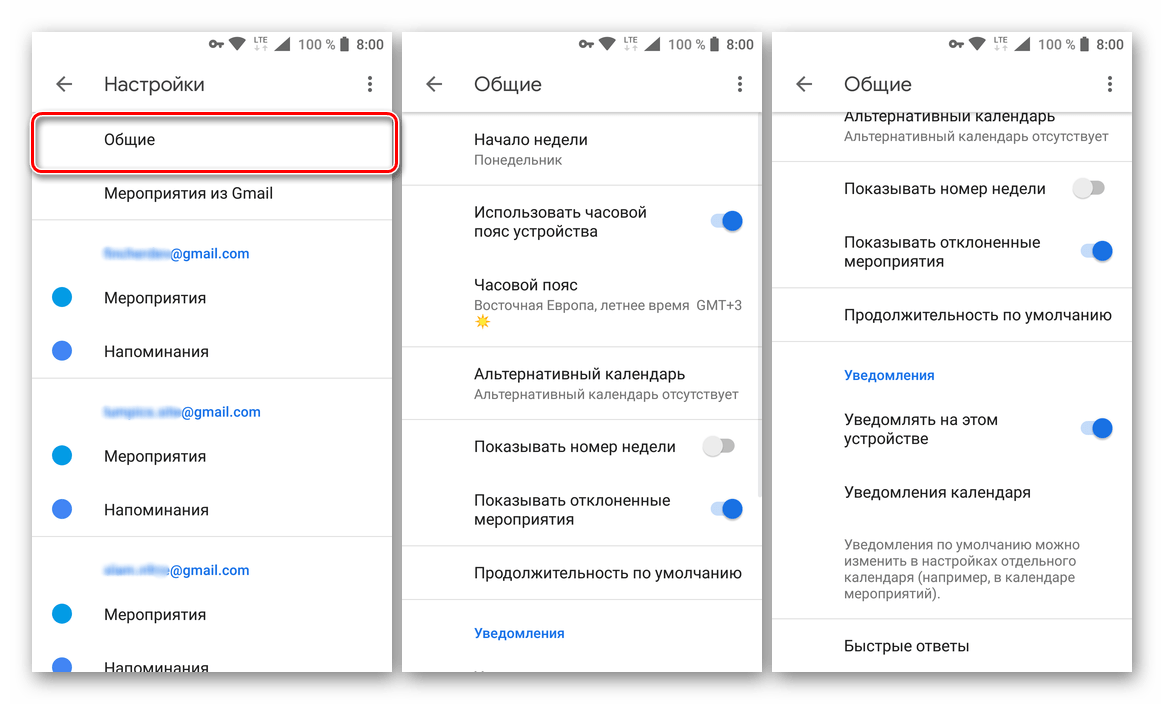

Мануал по созданию удобного планировщика повторяющихся действий....

Мануал по созданию удобного планировщика повторяющихся действий....

14 03 2024 20:34:53

Под какие треки работают интернет-маркетологи, копирайтеры и другие специалисты digital-рынка....

Под какие треки работают интернет-маркетологи, копирайтеры и другие специалисты digital-рынка....

13 03 2024 13:34:40

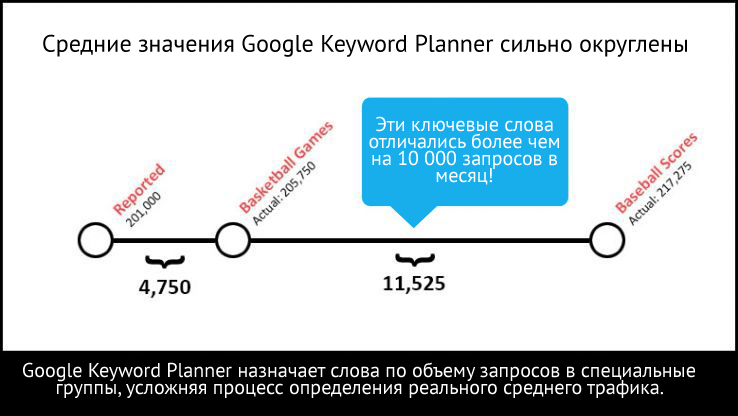

Небольшой набор секретов по работе с Планировщиком ключевых слов гугла...

Небольшой набор секретов по работе с Планировщиком ключевых слов гугла...

12 03 2024 4:19:26

Как составить список, работа с которым займет меньше времени, чем обычно. На примере обработки запросов в ювелирной тематике....

Как составить список, работа с которым займет меньше времени, чем обычно. На примере обработки запросов в ювелирной тематике....

11 03 2024 10:12:30

Как сделать склейку и сохранить трафик, распространенные ошибки при склеивании. Узнать больше!...

Как сделать склейку и сохранить трафик, распространенные ошибки при склеивании. Узнать больше!...

10 03 2024 19:57:53

Direct way. Как вложить 200 у.е. и получить 800 у.е....

Direct way. Как вложить 200 у.е. и получить 800 у.е....

09 03 2024 13:43:53

Улучшайте свой уровень английского. Упражнения для В1 — Intermediate («Средний+»). Узнать больше!...

Улучшайте свой уровень английского. Упражнения для В1 — Intermediate («Средний+»). Узнать больше!...

08 03 2024 21:52:42

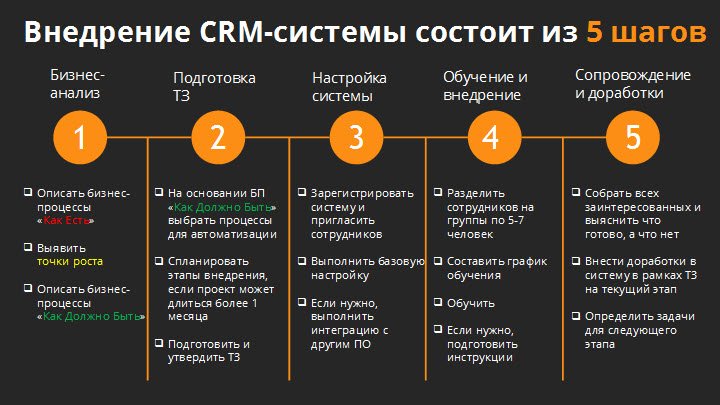

В этой статье мы поговорим про принципы работы СRM-системы. Это базовые моменты, прояснив которые СRM перестанет быть для вас чем-то сложным и непонятным....

В этой статье мы поговорим про принципы работы СRM-системы. Это базовые моменты, прояснив которые СRM перестанет быть для вас чем-то сложным и непонятным....

07 03 2024 12:35:24

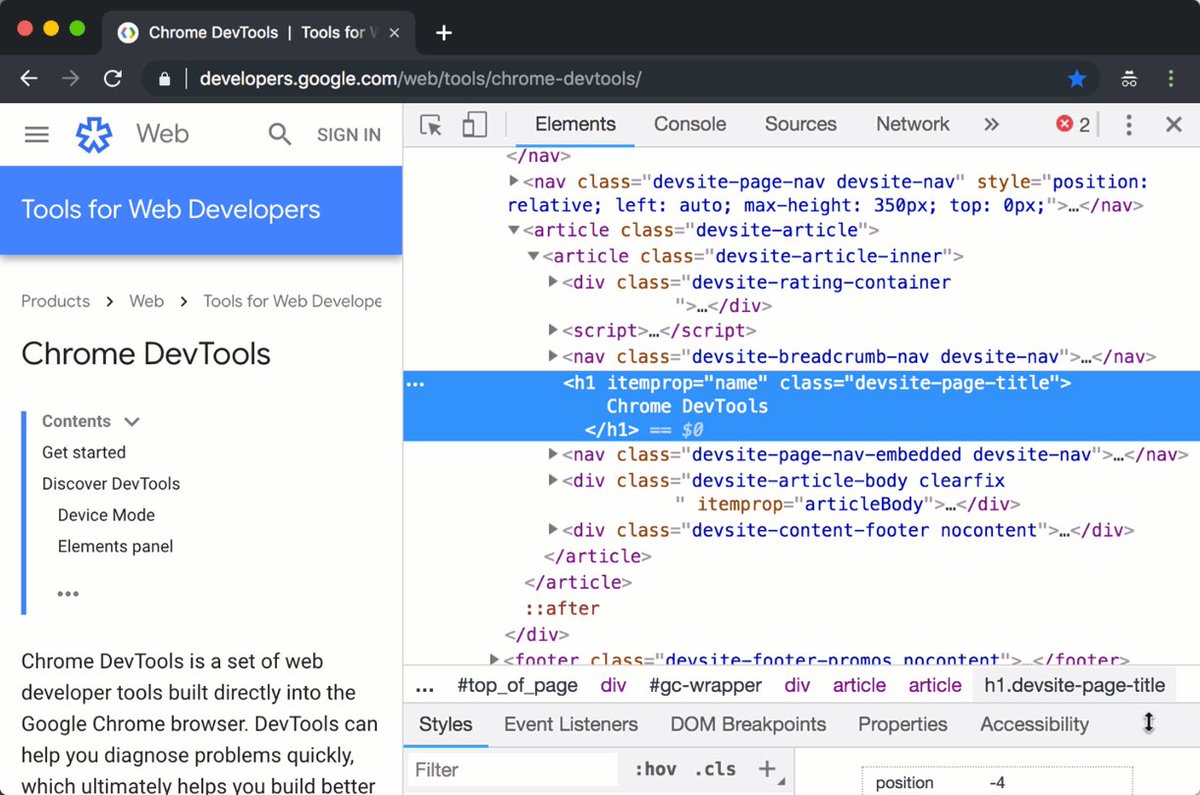

Какие возможности дает Chrome DevTools для SEO-оптимизации...

Какие возможности дает Chrome DevTools для SEO-оптимизации...

06 03 2024 23:50:58

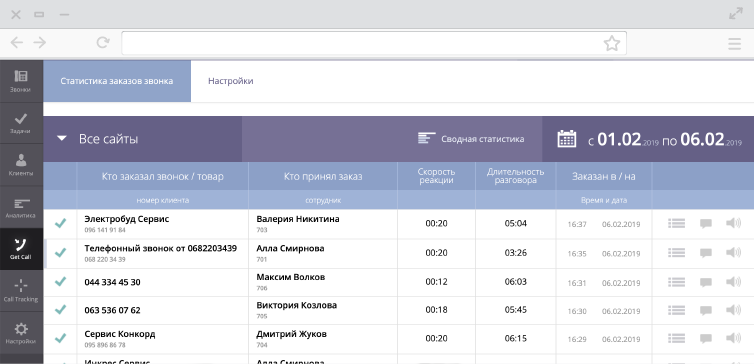

Звук телефонного звонка важен и для пользователя интернета. Как точно рассчитать полученную прибыль и рентабельность инвестиций в рекламу...

Звук телефонного звонка важен и для пользователя интернета. Как точно рассчитать полученную прибыль и рентабельность инвестиций в рекламу...

05 03 2024 18:49:30

Отчет «Многокaнaльные последовательности» в Google ***ytics помогает оценить влияние каждого канала, сделать выводы о работе рекламных кампаний — понять их вклад и участие в цепочке до совершения конверсии. Показываем на примере....

04 03 2024 21:16:34

И эксперт, и агент. Анонимный покупатель — специальная проверка бизнес-процессов до и во время рекламной кампании...

И эксперт, и агент. Анонимный покупатель — специальная проверка бизнес-процессов до и во время рекламной кампании...

03 03 2024 17:23:40

Ringostat и Binotel. Сравнение главных сервисов для коллтрекинга в Украине...

Ringostat и Binotel. Сравнение главных сервисов для коллтрекинга в Украине...

02 03 2024 23:51:23

Терялись ли вы некогда в лабиринте Википедии из внутренних ссылок и побочных статей? Представьте, насколько непредсказуемым он может стать через несколько десятилетий....

Терялись ли вы некогда в лабиринте Википедии из внутренних ссылок и побочных статей? Представьте, насколько непредсказуемым он может стать через несколько десятилетий....

01 03 2024 8:46:21

Таблицы Google позволят перенести рекламную кампанию и сохранить при этом ключевые слова в разных типах соответствия. Подробный мануал — в новом посте....

Таблицы Google позволят перенести рекламную кампанию и сохранить при этом ключевые слова в разных типах соответствия. Подробный мануал — в новом посте....

29 02 2024 6:19:27

Еще:

понять и запомнить -1 :: понять и запомнить -2 :: понять и запомнить -3 :: понять и запомнить -4 :: понять и запомнить -5 :: понять и запомнить -6 :: понять и запомнить -7 ::