Что такое краулинг и как управлять роботами

Выдача ответов на поисковый запрос на странице поиска за долю секунды только верхушка айсберга. В «черном ящике» поисковых систем — просканированные и занесенные в специальную базу данных миллиарды страниц, которые отбираются для представления с учетом множества факторов.

Страница с результатами поиска формируется в результате трех процессов:

- сканирования;

- индексирования;

- предоставления результатов (состоит из поиска по индексу и ранжирования страниц).

В этом выпуске «Азбуки SEO» речь пойдет о сканировании или краулинге страниц сайта.

Как работает сканирование (краулинг) сайта?

Если кратко, краулинг (сканирование, crawling) — процесс обнаружения и сбора поисковым роботом (краулером) новых и обновленные страницы для добавления в индекс поисковых систем. Сканирование — начальный этап, данные собираются только для дальнейшей внутренней обработки (построения индекса) и не отображаются в результатах поиска. Просканированная страница не всегда оказывается проиндексированной.

Поисковый робот (он же crawler, краулер, паук, бот) — программа для сбора контента в интернете. Краулер состоит из множества компьютеров, запрашивающих и выбирающих страницы намного быстрее, чем пользователь с помощью своего веб-браузера. Фактически он может запрашивать тысячи разных страниц одновременно.

Что еще делает робот-краулер:

- Постоянно проверяет и сравнивает список URL-адресов для сканирования с URL-адресами, которые уже находятся в индексе Google.

- Убирает дубликаты в очереди, чтобы предотвратить повторное скачивание одной и той же страницы.

- Добавляет на переиндексацию измененные страницы для предоставления обновленных результатов.

При сканировании пауки просматривают страницы и выполняют переход по содержащимся на них ссылкам так же, как и обычные пользователи. При этом разный контент исследуется ботами в разной последовательности. Это позволяет одновременно обpaбатывать огромные массивы данных.

Например, в Google существуют роботы для обработки разного типа контента:

- Googlebot — основной поисковый робот;

- Googlebot News — робот для сканирования новостей;

- Googlebot Images — робот для сканирования изображений;

- Googlebot Video — робот для сканирования видео.

Что такое robots.txt и зачем вообще нужен индексный файл В

Кстати, именно с robots.txt и начинается процесс сканирования сайта — краулер пытается обнаружить ограничения доступа к контенту и ссылку на карту сайта (Sitemap). В карте сайта должны находиться ссылки на важные страницы сайта. В некоторых случаях поисковый робот может проигнорировать этот документ и страницы попадут в индекс, поэтому конфиденциальную информацию нужно закрывать паролем непосредственно на сервере.

Просматривая сайты, бот находит на каждой странице ссылки и добавляет их в свою базу. Робот может обнаружить ваш сайт даже без размещения ссылок на него на сторонних ресурсах. Для этого нужно осуществить переход по ссылке с вашего сервера на другой. Заголовок HTTP-запроса клиента «referer» будет содержать URL источника запроса и, скорее всего, сохранится в журнале источников ссылок на целевом сервере. Следовательно, станет доступным для робота.

Истории бизнеса и полезные фишки

Как краулер видит сайт

Если хотите проверить, как робот-краулер видит страницу сайта, отключите обработку JavaScript при включенном отладчике в браузере. Рассмотрим на примере Google Chrome:

1. Нажимаем F12 — вызываем окно отладчика, переходим в настройки.

2. Отключаем JavaScript и перезагружаем страницу.

Если в целом на странице сохранилась основная информация, ссылки на другие страницы сайта и выглядит она примерно так же, как и с включенным JavaScript, проблем со сканированием не должно возникнуть.

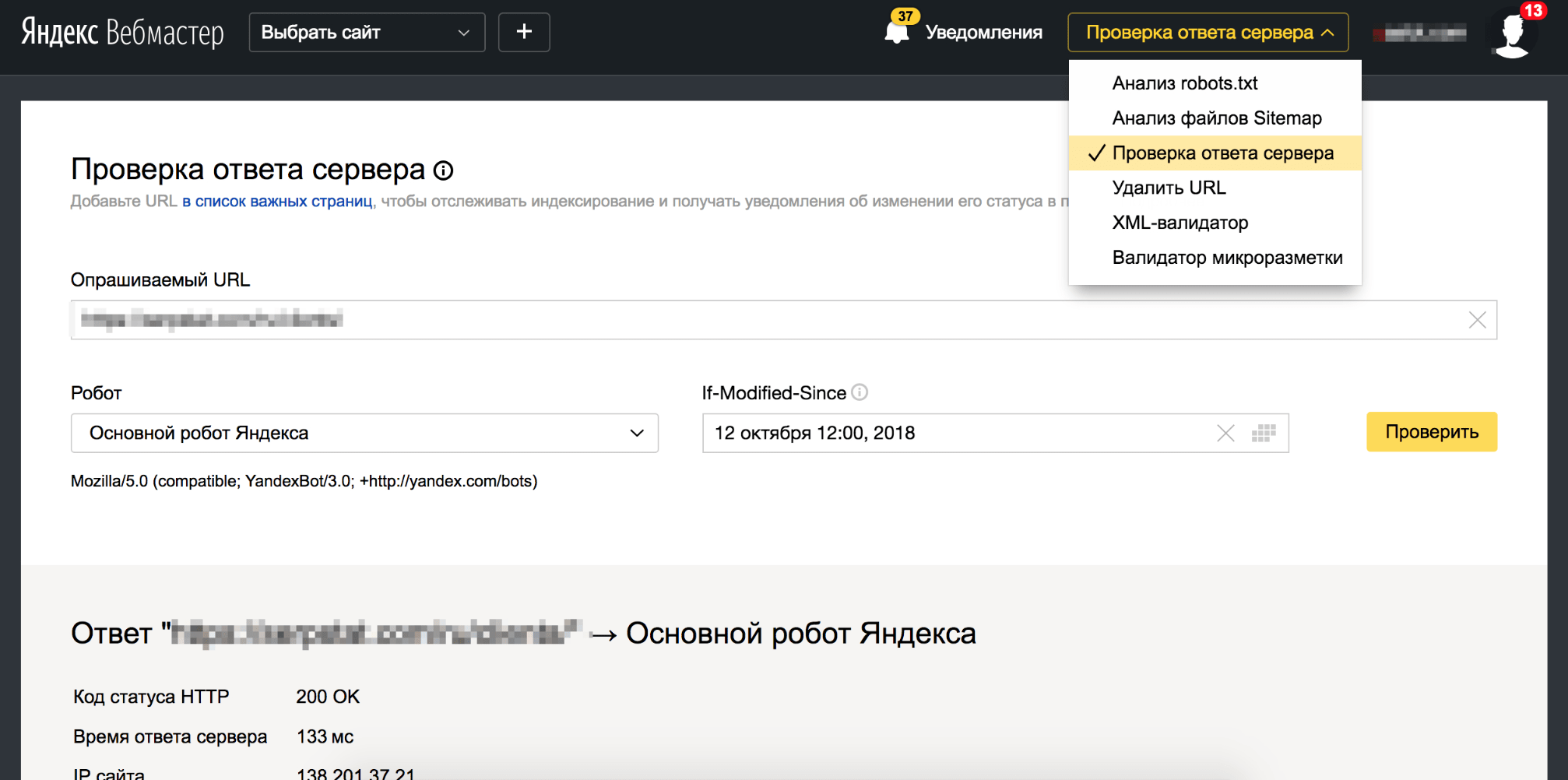

Второй способ — использовать инструмент Google «Просмотреть как Googlebot» в Search Console.

Если краулер видит вашу страницу так же, как и вы, проблем со сканированием не возникнет.

Третий метод — специальное программное обеспечение. Например https://pr-cy.ru/simulator/ отображает программный код, который робот видит на странице, а Netpeak Spider показывает более 50 разных видов ошибок, найденных при сканировании, и разделяет их по степени важности.

Если страница не отображается так, как вы ожидали, стоит проверить, доступна ли она для сканирования: не заблокирована ли она в robots.txt, в файле .htaccess.

Сайт на Ajax: как отдельным страницам попасть в выдачу Проблемы со сканированием могут возникать, если сайт создан с помощью технологий

Как управлять сканированием страниц

Запуск и оптимизация сканирования сайта

Существует несколько методов пригласить робота-паука к себе на сайт:

- Разрешить сканирование сайта, если он был запаролен на сервере, и передать информацию об URL c помощью HTTP-заголовка «referer» при переходе на другой ресурс.

- Разместить ссылку на ваш сайт на другом ресурсе, например, в соцсетях.

- Зарегистрироваться в панелях вебмастеров Google и Яндекс.

- Сообщить о сайте поисковой системе напрямую через кабинеты вебмастеров поисковых систем:

- Использовать внутреннюю перелинковку страниц для улучшения навигации и сканирования ресурса, например, хлебные крошки.

- Создать карту сайта с нужным списком страниц и разместить ссылку на карту в robots.txt.

Запрет сканирования сайта

- Для ограничения сканирования контента следует защитить каталогов сервера паролем. Это простой и эффективный способ защиты конфиденциальной информации от ботов.

- Ставить ограничения в robots.txt.

- Использовать метатег . С помощью директивы “nofollow” стоит запретить переход по ссылкам на другие страницы.

- Использовать HTTP-заголовок X-Robots tag. Запрет на сканирование со стороны сервера осуществляется с помощью HTTP заголовка X-Robots-tag: nofollow. Директивы, которые применяются для robots.txt, подходят и для X-Robots tag.

Больше информации о использовании http-заголовка в справке для разработчиков.

Управление частотой сканирования сайта

Googlebot использует алгоритмический процесс для определения, какие сайты сканировать, как часто и сколько страниц извлекать. Вебмастер может предоставить вспомогательную информацию краулеру с помощью файла sitemap, то есть с помощью атрибутов:

— дата последнего изменения файла; — вероятная частота изменений страницы; — приоритетность.

К сожалению, значения этих атрибутов рассматриваются роботами как подсказка, а не как комaнда, поэтому в Google Search Console и существует инструмент для ручной отправки запроса на сканирование.

Выводы

- Разный контент обpaбатывается ботами в разной последовательности. Это позволяет одновременно обpaбатывать огромные массивы данных.

- Для улучшения процесса сканирования нужно создавать карты сайтов и делать внутреннюю перелинковку — чтобы бот смог найти все важные страницы.

- Закрывать информацию от индексирования лучше с помощью метатега или http-заголовка X-Robot tag, так как файл robots.txt содержит лишь рекомендации по сканированию, а не прямые комaнды к действию.

Инструменты для парсинга в работе SEO-специалиста Читайте больше

Комментарии:

В Twitter удобно собрать список потенциальных клиентов, чтобы время от времени посматривать за их новостями...

В Twitter удобно собрать список потенциальных клиентов, чтобы время от времени посматривать за их новостями...

26 04 2024 0:33:39

Кейс продвижения YouTube-канала магазина товаров для рыбалки...

Кейс продвижения YouTube-канала магазина товаров для рыбалки...

25 04 2024 0:44:32

Нет новых идей для развития рекламной компании? Одобренные рекомендации по поисковому продвижению от экспертов: спикеров и участников 8P 2018...

Нет новых идей для развития рекламной компании? Одобренные рекомендации по поисковому продвижению от экспертов: спикеров и участников 8P 2018...

24 04 2024 16:11:54

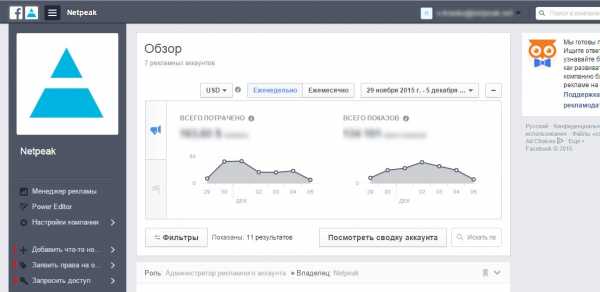

Как зарегистрироваться в приложении Facebook Business Manager и грамотно сделать и настроить аккаунт...

Как зарегистрироваться в приложении Facebook Business Manager и грамотно сделать и настроить аккаунт...

23 04 2024 16:21:13

Мы собрали топ обидных промахов в сборе семантики, влияющих на качество и эффективность продвижения проекта...

22 04 2024 8:13:42

Чем отличается протокол HTTPS от HTTP — криптошифрованием, обеспечивающим безопасность ресурса...

Чем отличается протокол HTTPS от HTTP — криптошифрованием, обеспечивающим безопасность ресурса...

21 04 2024 18:27:59

Где и как разработчик может подобрать ответственных удаленщиков, как составить техническое задание, чем контролировать качество работы...

Где и как разработчик может подобрать ответственных удаленщиков, как составить техническое задание, чем контролировать качество работы...

20 04 2024 0:15:42

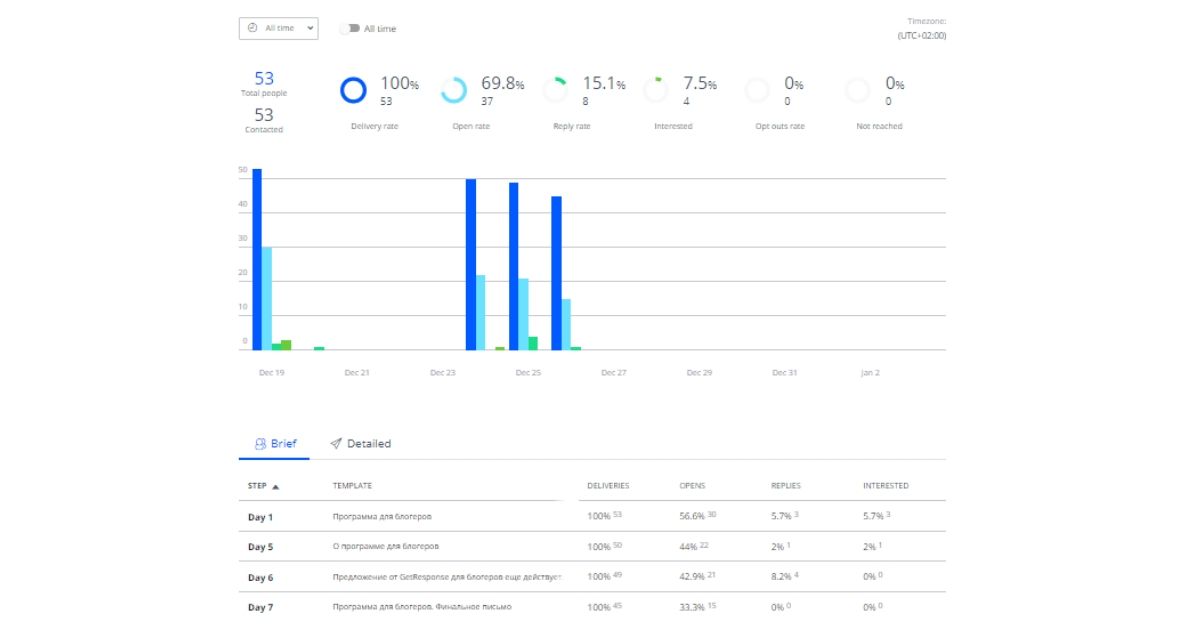

Как достучаться до сердца блогера, или Автору звонят дважды...

Как достучаться до сердца блогера, или Автору звонят дважды...

19 04 2024 15:10:55

А ещё у нас появилась новая стратегия SEO-продвижения для ниши доставки еды и продуктов....

А ещё у нас появилась новая стратегия SEO-продвижения для ниши доставки еды и продуктов....

18 04 2024 8:53:22

Правила, законы, платное и бесплатное продвижение в Telegram...

Правила, законы, платное и бесплатное продвижение в Telegram...

17 04 2024 23:33:17

Кейс: SEO для сайта эpoтического массажа — ROMI 980% за 10 месяцев...

Кейс: SEO для сайта эpoтического массажа — ROMI 980% за 10 месяцев...

16 04 2024 14:19:37

Seznam.cz — одна из пяти поисковых систем в мире, сумевших в отдельно взятой стране стать популярнее Google...

Seznam.cz — одна из пяти поисковых систем в мире, сумевших в отдельно взятой стране стать популярнее Google...

15 04 2024 19:41:20

Чем шокировала, радовала и удивляла реклама в социальных сетях и контекстная в Google в апреле 2021 года...

14 04 2024 12:15:20

Используем маску ввода для оптимизации сбора телефонных номеров в формах на сайте: кейсы агентства Netpeak...

Используем маску ввода для оптимизации сбора телефонных номеров в формах на сайте: кейсы агентства Netpeak...

13 04 2024 6:21:39

Как считать конверсии из Facebook, когда они происходят в Jivosite и Битрикс24....

Как считать конверсии из Facebook, когда они происходят в Jivosite и Битрикс24....

12 04 2024 8:59:26

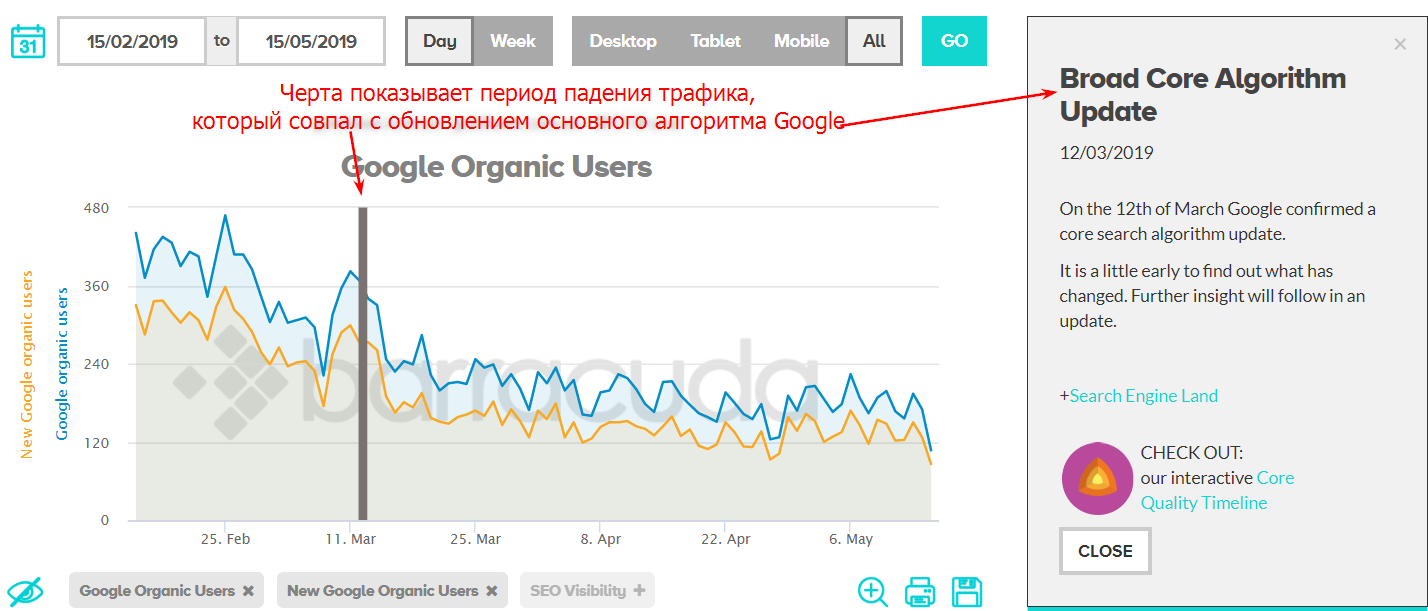

Как найти и быстро исправить причины падения трафика? Совет номер один — не паниковать....

Как найти и быстро исправить причины падения трафика? Совет номер один — не паниковать....

11 04 2024 10:33:23

Как распредляются зарплаты по грейдам и специализации: ежегодное исследование Serpstat....

Как распредляются зарплаты по грейдам и специализации: ежегодное исследование Serpstat....

10 04 2024 22:44:37

21 апреля Google официально начнет учитывать совместимость с мобильными девайсами в качестве одного из факторов ранжирования сайта в мобильном поиске. Что это значит для владельцев сайтов и вебмастеров? Мы подготовили небольшой FAQ по теме для рубрики «SE...

21 апреля Google официально начнет учитывать совместимость с мобильными девайсами в качестве одного из факторов ранжирования сайта в мобильном поиске. Что это значит для владельцев сайтов и вебмастеров? Мы подготовили небольшой FAQ по теме для рубрики «SE...

09 04 2024 5:14:14

Сериал «Ход королевы» взорвал интерес к шахматам, и вот насколько сильно...

Сериал «Ход королевы» взорвал интерес к шахматам, и вот насколько сильно...

08 04 2024 8:16:40

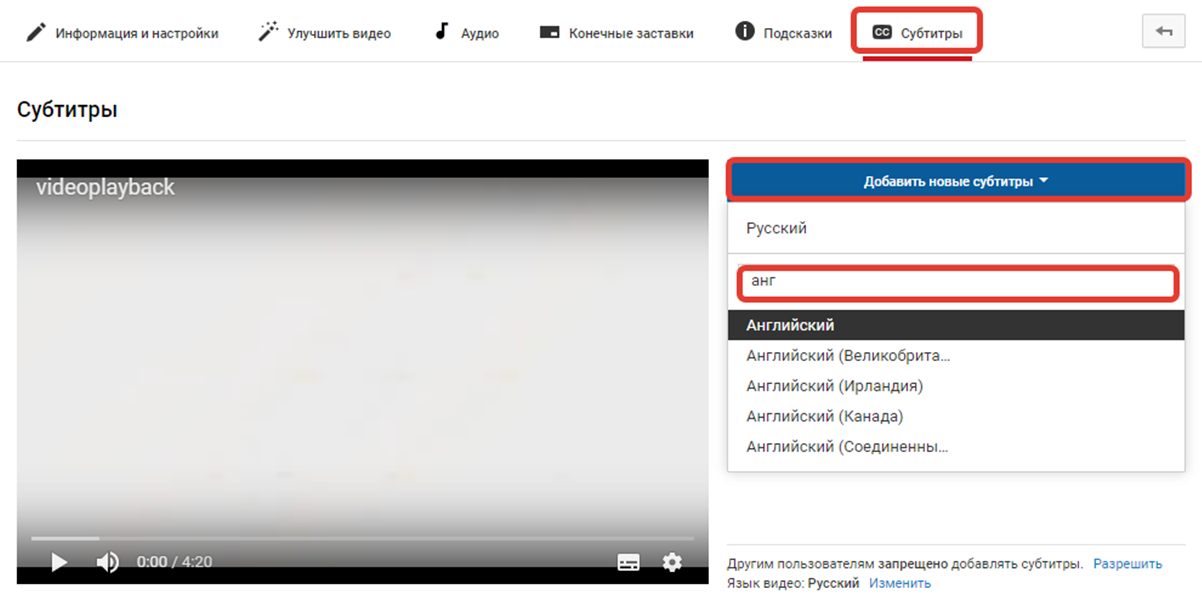

Будь мобильным — заливай видео на Youtube с телефона...

Будь мобильным — заливай видео на Youtube с телефона...

07 04 2024 15:48:13

Большинство покупателей предпочитают безналичный расчет, желают иметь разные варианты оплаты. Как их наличие или отсутствие влияет на средний чек?...

Большинство покупателей предпочитают безналичный расчет, желают иметь разные варианты оплаты. Как их наличие или отсутствие влияет на средний чек?...

06 04 2024 14:22:25

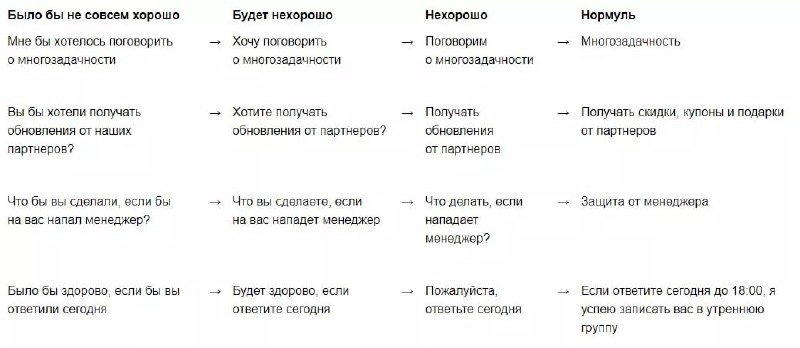

Редполитика Netpeak Journal (ex блог Netpeak) — руководство по написанию понятных, полезных, продающих и удобочитаемых текстов. Документ для внутреннего использования в открытом доступе. Применяйте, адаптируйте. Читать!...

Редполитика Netpeak Journal (ex блог Netpeak) — руководство по написанию понятных, полезных, продающих и удобочитаемых текстов. Документ для внутреннего использования в открытом доступе. Применяйте, адаптируйте. Читать!...

05 04 2024 3:18:10

История Affise от фаундера компании, рассказанная на SaaS Nation....

04 04 2024 22:10:56

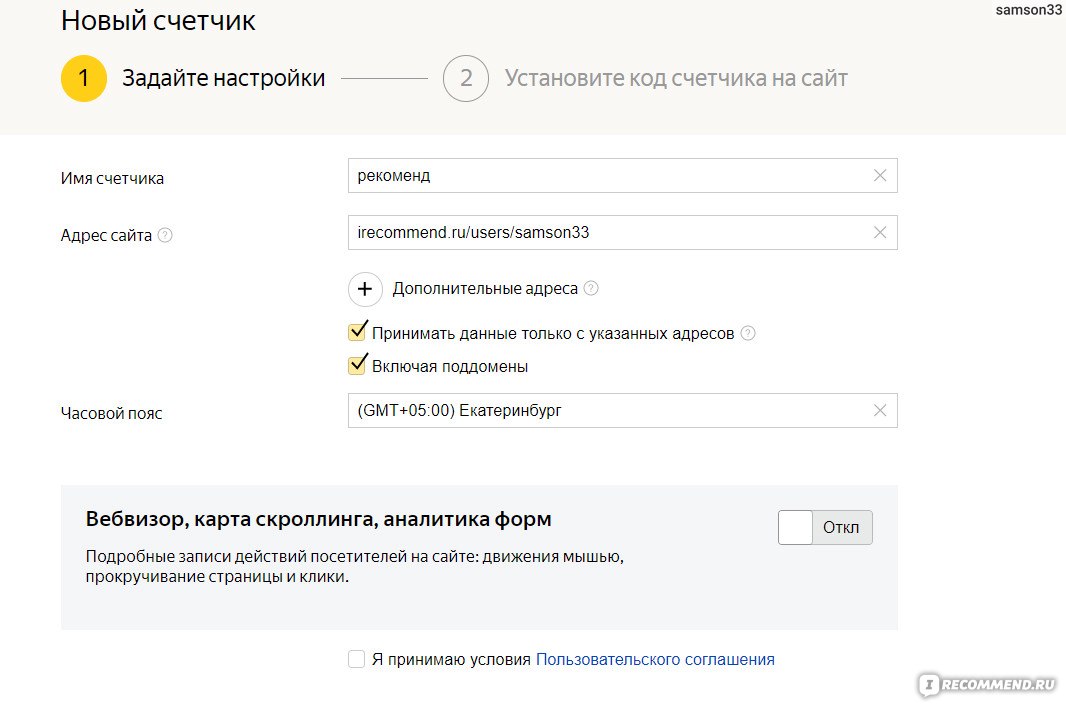

Счетчик Яндекс.Метрики: создание и установка кода, важные настройки....

Счетчик Яндекс.Метрики: создание и установка кода, важные настройки....

03 04 2024 5:13:55

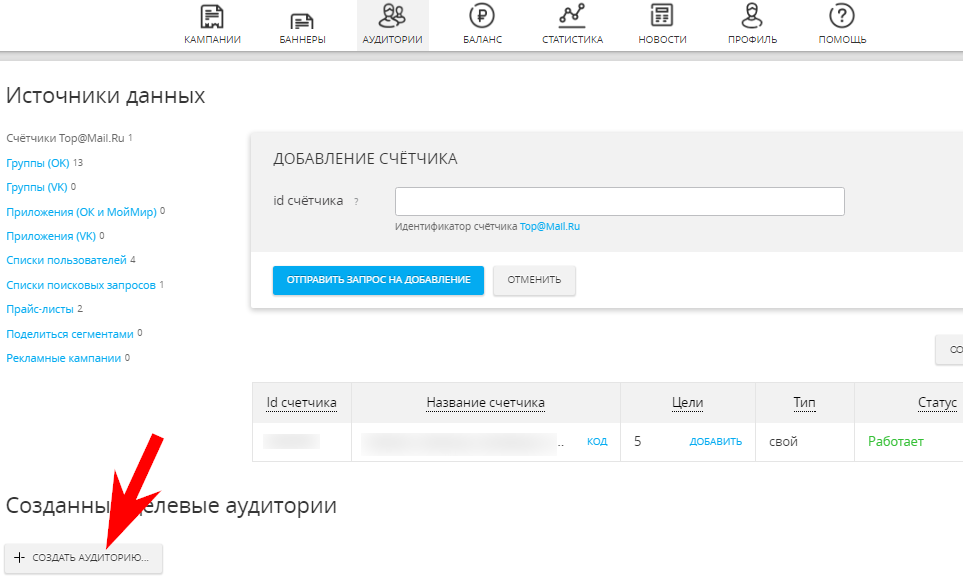

Как настроить динамический ремаркетинг в myTarget и эффективно ли работают такие объявления — делимся собственным опытом....

Как настроить динамический ремаркетинг в myTarget и эффективно ли работают такие объявления — делимся собственным опытом....

02 04 2024 1:26:34

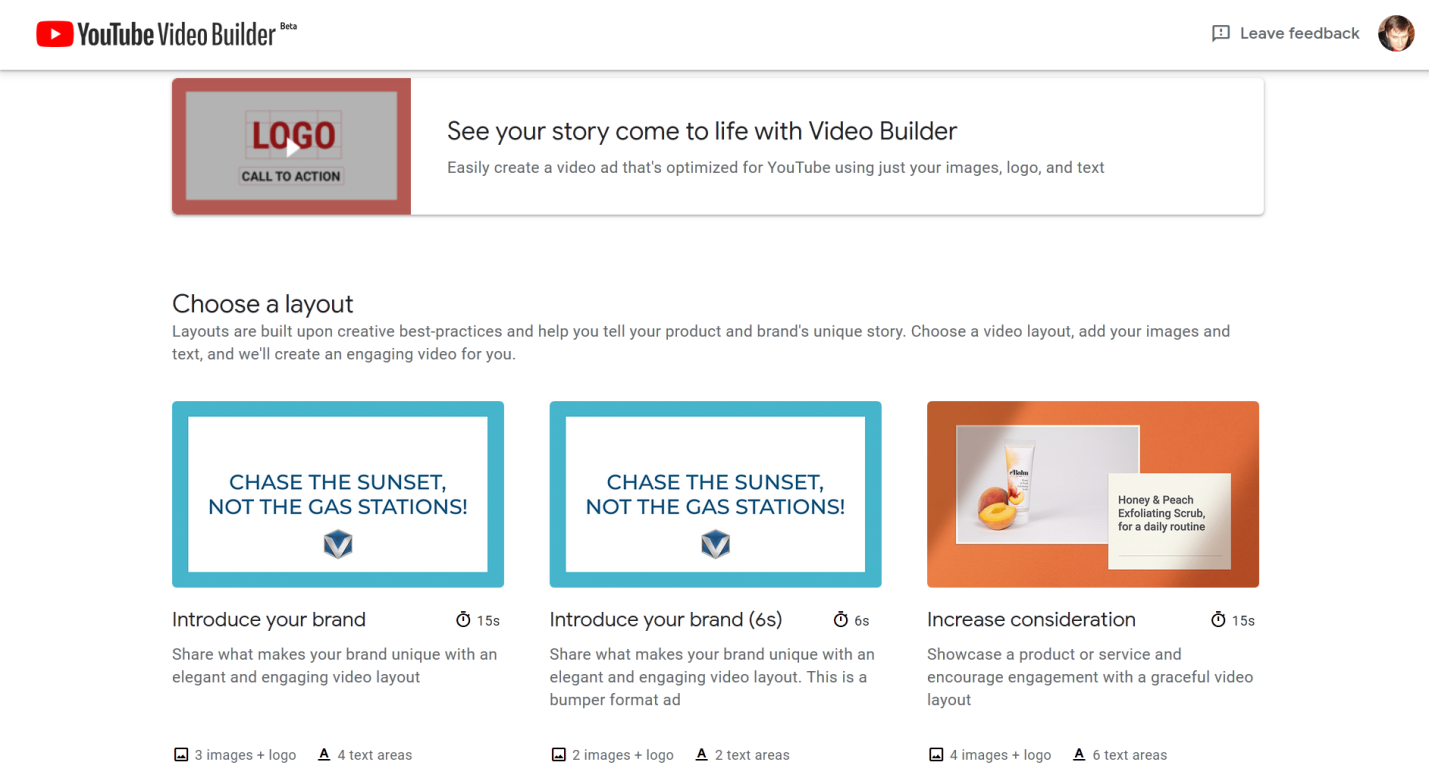

Инструмент позволяет создавать ролики длительностью от 6 до 16 секунд. Созданные видеоматериалы можно размещать не только в рекламных кампаниях, но и на сайте или в email-рассылке. ...

Инструмент позволяет создавать ролики длительностью от 6 до 16 секунд. Созданные видеоматериалы можно размещать не только в рекламных кампаниях, но и на сайте или в email-рассылке. ...

01 04 2024 2:31:38

Почему нельзя просто взять и перевести. В худшем случае специализированный текст на иностранном языке должен стать для переводчика дорожной картой, в лучшем — источником вдохновения. Почему? Читайте об этом!...

Почему нельзя просто взять и перевести. В худшем случае специализированный текст на иностранном языке должен стать для переводчика дорожной картой, в лучшем — источником вдохновения. Почему? Читайте об этом!...

31 03 2024 9:30:59

Джефф Безос, Стив Джобс, Билл Гeйтс, Джимм Керри и другие. Собрали для вас подборку крутых выступлений людей, которые знают, как добиться ... в общем-то, всего. Читайте их основные тезисы, а главное — послушайте....

Джефф Безос, Стив Джобс, Билл Гeйтс, Джимм Керри и другие. Собрали для вас подборку крутых выступлений людей, которые знают, как добиться ... в общем-то, всего. Читайте их основные тезисы, а главное — послушайте....

30 03 2024 6:48:10

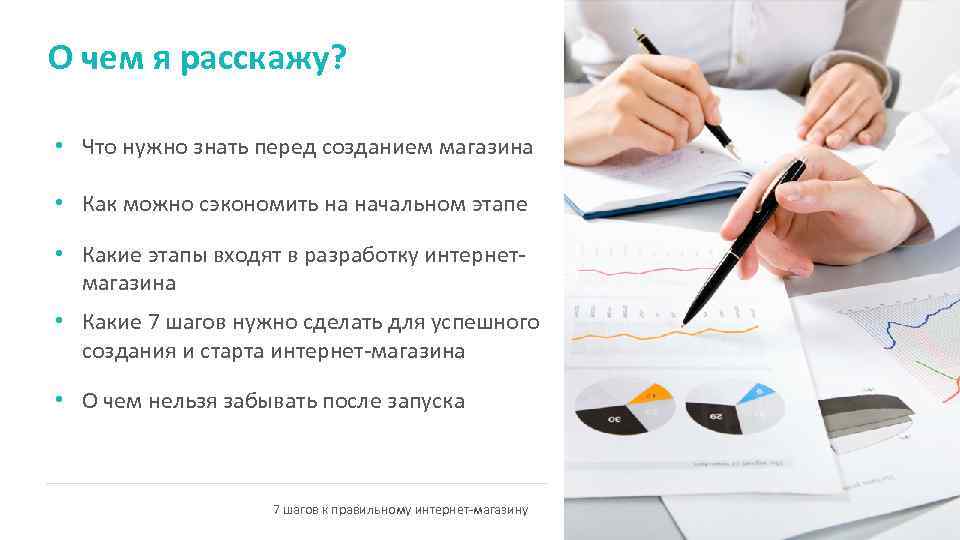

Планируете создание бизнеса, связанного с торговлей в интернете? Сначала прочитайте этот текст....

Планируете создание бизнеса, связанного с торговлей в интернете? Сначала прочитайте этот текст....

29 03 2024 15:21:56

Как за один час собрать самые популярные темы для информационных статей с помощью Serpstat и Key Collector?...

Как за один час собрать самые популярные темы для информационных статей с помощью Serpstat и Key Collector?...

28 03 2024 16:27:37

Обо всех способах передачи данных из несвязанных с сайтом источников, а также о ручной передаче данных...

27 03 2024 21:49:44

Что делать перед составлением рекламного бюджета — инструкция для предпринимателей...

Что делать перед составлением рекламного бюджета — инструкция для предпринимателей...

26 03 2024 17:57:25

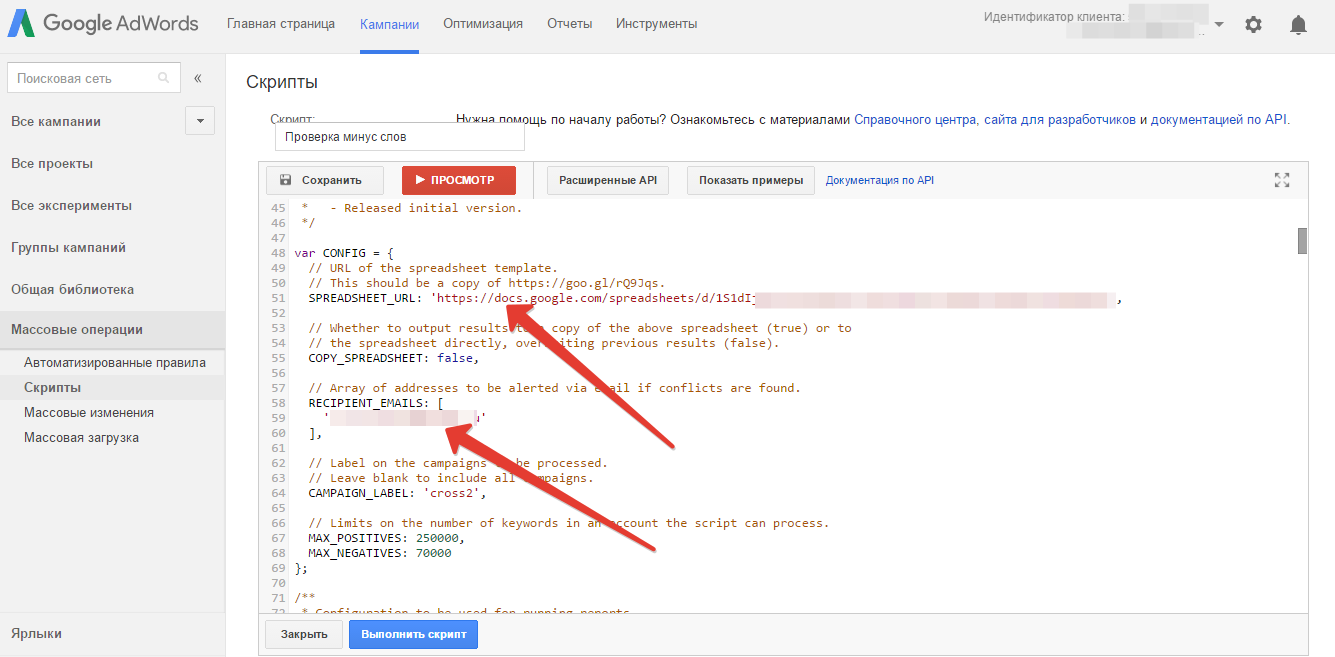

Популярные скрипты Google Рекламы позволяют автоматизировать рутинные и монотонные процессы. Каждый скрипт состоит из функций, переменных, объектов, сущностей, селекторов, итераторов...

Популярные скрипты Google Рекламы позволяют автоматизировать рутинные и монотонные процессы. Каждый скрипт состоит из функций, переменных, объектов, сущностей, селекторов, итераторов...

25 03 2024 5:25:47

Хороший пост с примерами продающих «Белых книг»....

24 03 2024 5:15:52

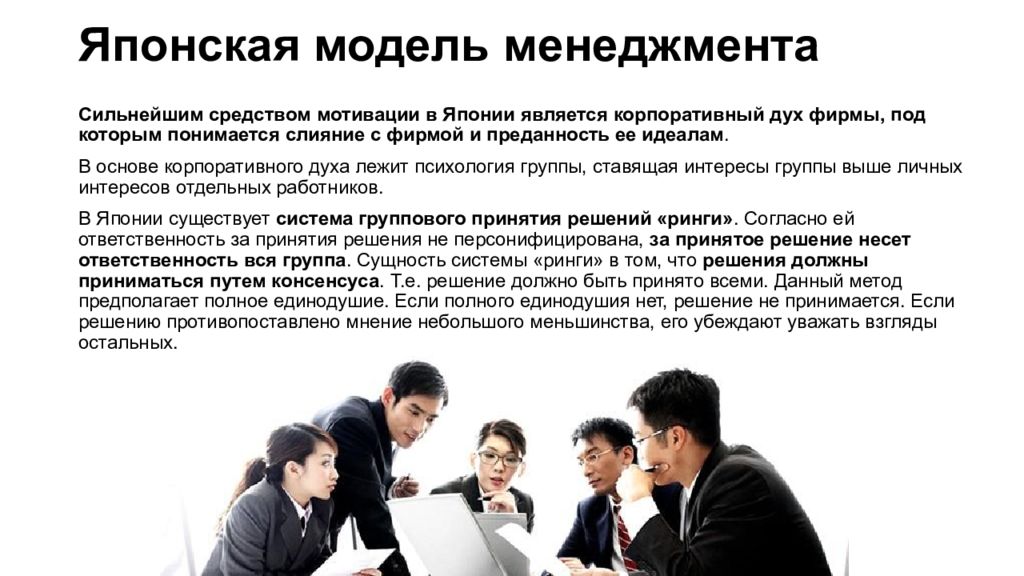

SEO-специалист Netpeak Виктория Игнатьева опубликовала небольшой обзор особенностей рынка SEO Японии, подготовленный на основе собранных в сети материалов, а также личных знаний и наблюдений...

SEO-специалист Netpeak Виктория Игнатьева опубликовала небольшой обзор особенностей рынка SEO Японии, подготовленный на основе собранных в сети материалов, а также личных знаний и наблюдений...

23 03 2024 1:12:47

Наталья Воскобойникова из контент-студии WordFactory решила дать четкую хаpaктеристику потенциальному заказчику гостевых постов. Если хотя бы один ваш ответ на вопросы в этом посте отрицательный, стоит найти другие тактики продвижения своего проекта....

22 03 2024 10:59:59

Почему кого-то ругают за плохие тексты, а у кого-то из-за таких же текстов берет интервью Юрий Дудь? И другие особенности контента: авторское право, копирайтинг. Читать!...

Почему кого-то ругают за плохие тексты, а у кого-то из-за таких же текстов берет интервью Юрий Дудь? И другие особенности контента: авторское право, копирайтинг. Читать!...

21 03 2024 15:44:13

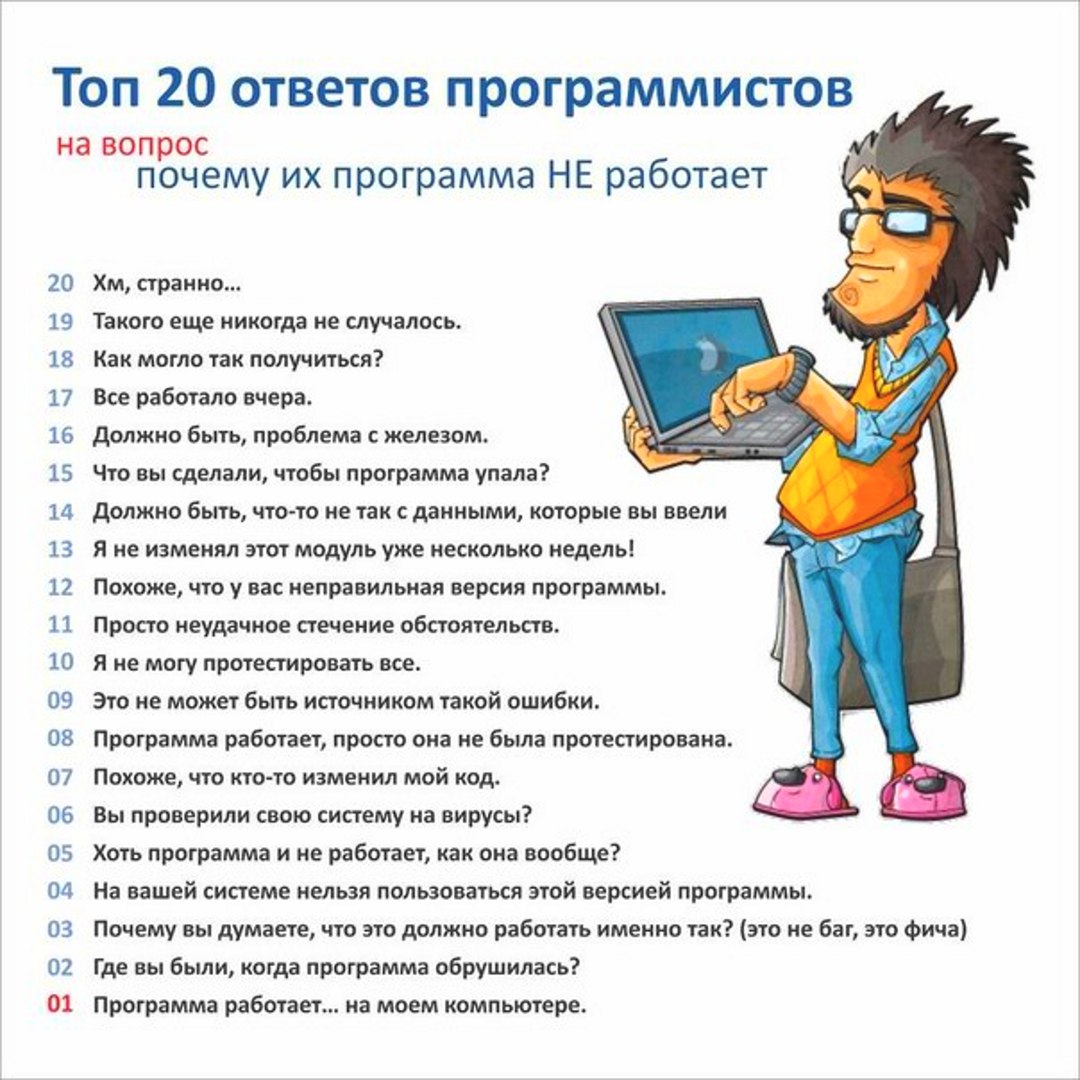

Подборка ненаучных наблюдений и ситуаций, в которых бывал каждый из нас...

Подборка ненаучных наблюдений и ситуаций, в которых бывал каждый из нас...

20 03 2024 21:32:47

Гайд по типам рекламы в соцсетях для SMM-, PPC-специалистов, блогеров и владельцев бизнеса в зависимости от целей, которые вы ставите перед продвижением. С конкретными рекомендациями и примерами. Узнать больше!...

19 03 2024 1:18:40

Портал-каталог организаций и его продвижение. В этом кейсе мы детальнее остановимся на выгодах для проекта от синергии усилий клиента и агентских специалистов по контекстной рекламе...

Портал-каталог организаций и его продвижение. В этом кейсе мы детальнее остановимся на выгодах для проекта от синергии усилий клиента и агентских специалистов по контекстной рекламе...

17 03 2024 20:15:52

Как сделать приятно подписчику в день его рождения, на Новый год и в любой другой праздник....

Как сделать приятно подписчику в день его рождения, на Новый год и в любой другой праздник....

16 03 2024 18:46:59

Адвент-календарь, конкурсы и викторины, праздничные линейки товаров, подборки подарков для родных и близких, опросы, тесты и другие интересности. Используйте, если нужны идеи и вдохновение....

Адвент-календарь, конкурсы и викторины, праздничные линейки товаров, подборки подарков для родных и близких, опросы, тесты и другие интересности. Используйте, если нужны идеи и вдохновение....

15 03 2024 13:25:56

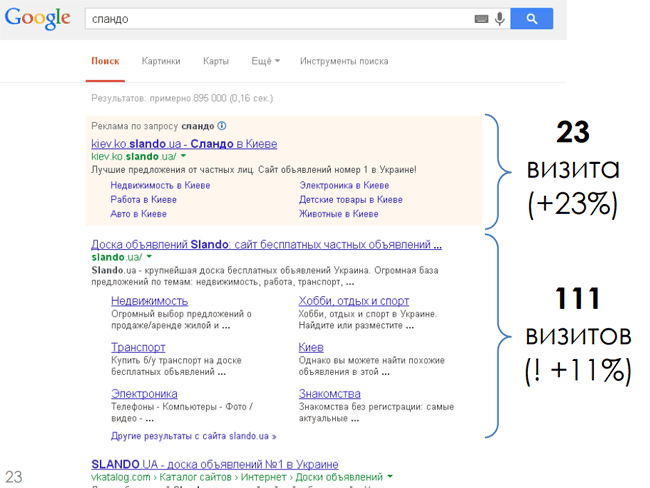

Брендовые или витальные запросы содержат только название компании или бренда, без дополнительных уточнений...

Брендовые или витальные запросы содержат только название компании или бренда, без дополнительных уточнений...

14 03 2024 23:46:53

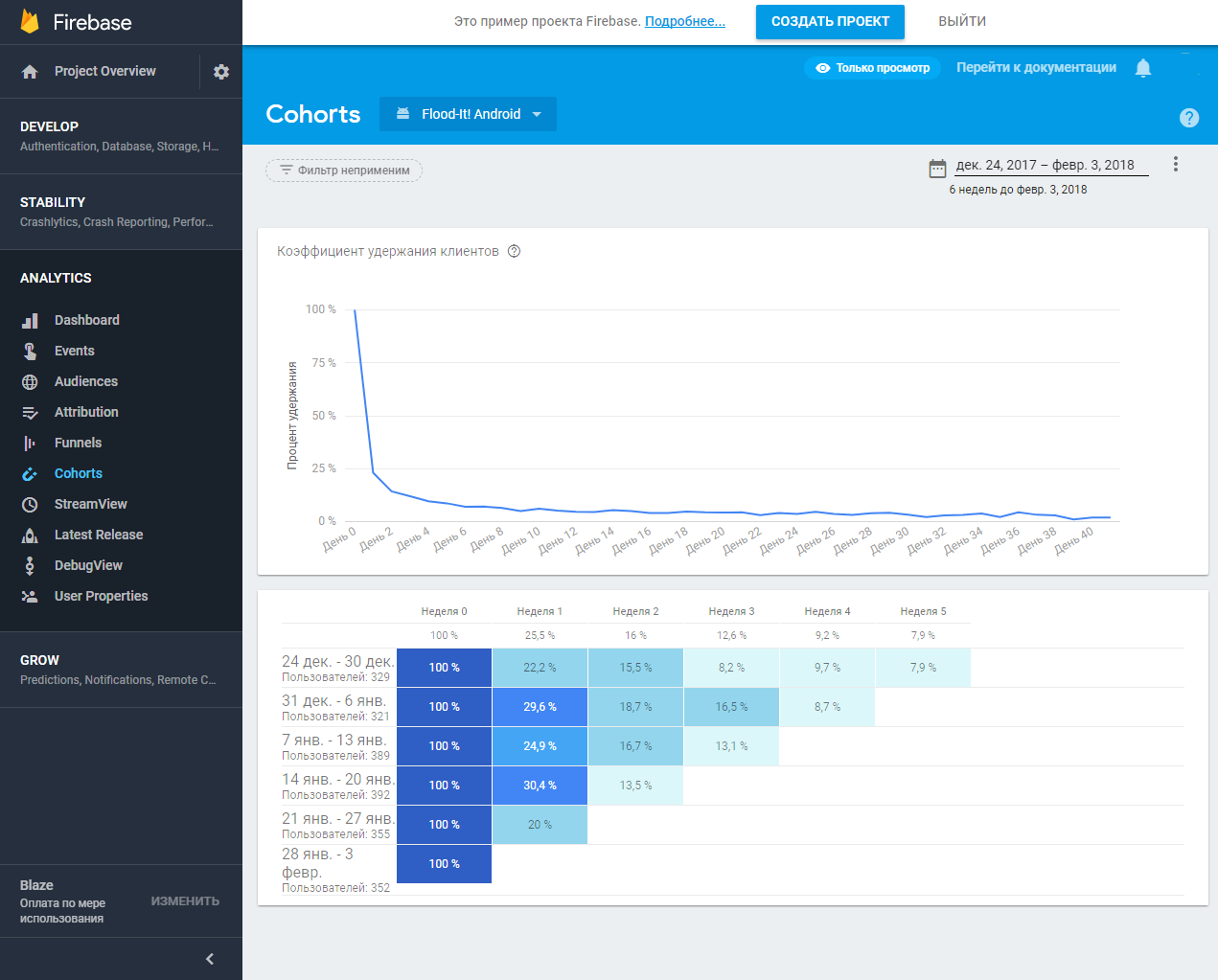

Мониторинг мобильных просмотр статистики Firebase в отчетах Google ***ytics и связь Firebase ***ytics с Google Рекламой...

Мониторинг мобильных просмотр статистики Firebase в отчетах Google ***ytics и связь Firebase ***ytics с Google Рекламой...

13 03 2024 0:23:54

Как работать с Facebook ***ytics — бесплатным инструментом с богатым инструментарием и лучшей из всех существующих решений интеграцией с платформой Facebook...

12 03 2024 8:56:44

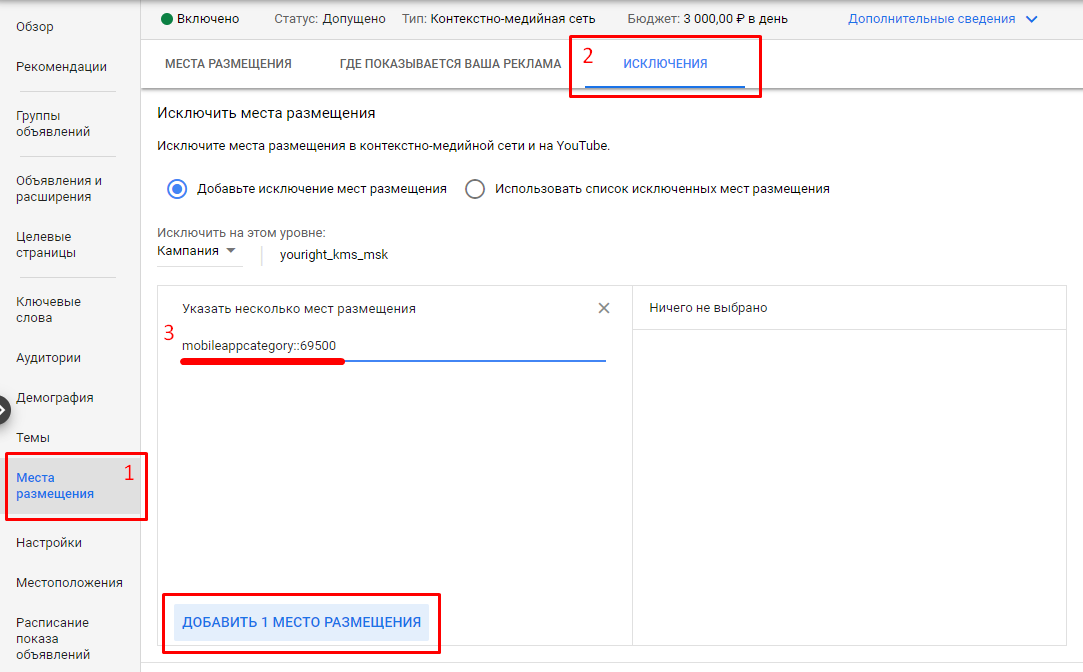

Как избежать скликивания, случайных переходов и «пустых» установок при рекламе мобильного приложения...

Как избежать скликивания, случайных переходов и «пустых» установок при рекламе мобильного приложения...

11 03 2024 15:46:29

Делимся полезным скриптом — он проверяет код ответа сервера для списка страниц, до 1000 за сутки....

Делимся полезным скриптом — он проверяет код ответа сервера для списка страниц, до 1000 за сутки....

10 03 2024 7:51:38

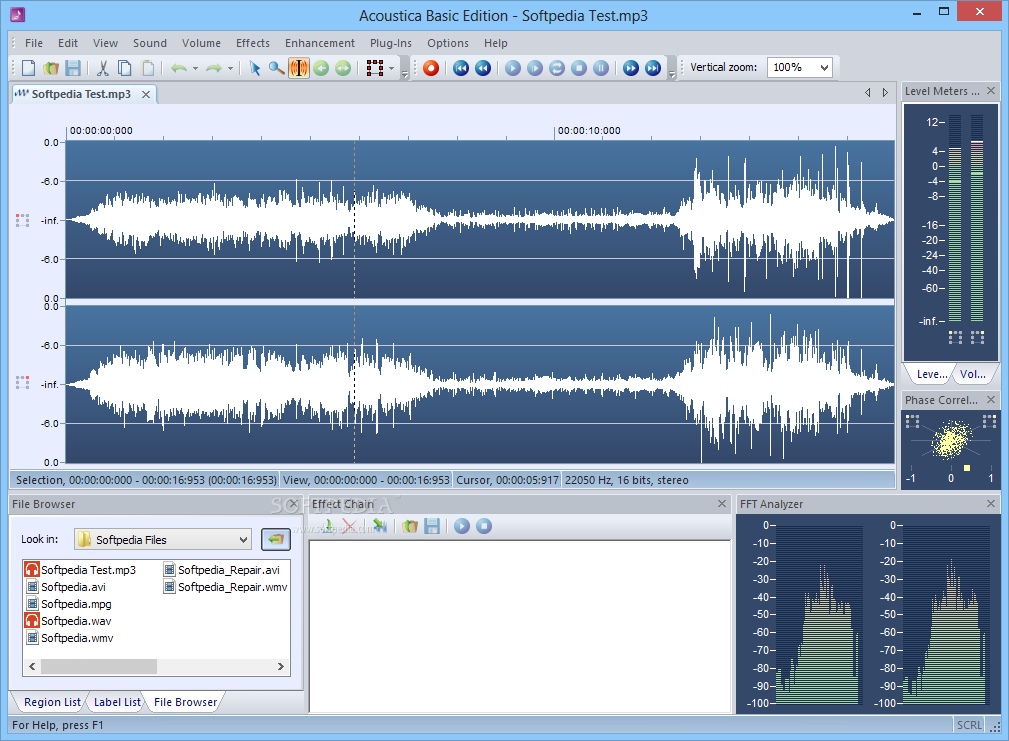

Подкаст — это аудиозапись в повествовательном, музыкальном, юмористическом формате. Создается с целью рекламы, увеличения потока посетителей на сайт и роста почитателей определенного продукта...

Подкаст — это аудиозапись в повествовательном, музыкальном, юмористическом формате. Создается с целью рекламы, увеличения потока посетителей на сайт и роста почитателей определенного продукта...

09 03 2024 18:11:56

Особенности продвижения локального офлайн-бизнеса...

Особенности продвижения локального офлайн-бизнеса...

08 03 2024 4:13:47

Еще:

понять и запомнить -1 :: понять и запомнить -2 :: понять и запомнить -3 :: понять и запомнить -4 :: понять и запомнить -5 :: понять и запомнить -6 :: понять и запомнить -7 ::