Что такое robots.txt и зачем вообще нужен индексный файл

Файл robots.txt вместе с xml-картой несёт, пожалуй, самую важную информацию о ресурсе: он показывает роботам поисковых систем, как именно «читать» сайт, какие страницы важны, а какие следует пропустить. Еще robots.txt — первая страница, на которую стоит смотреть, если на сайт внезапно упал трафик.

Что за роботс ти экс ти?

Файл robots.txt или индексный файл — обычный текстовый документ в кодировке UTF-8, действует для протоколов http, https, а также FTP. Файл дает поисковым роботам рекомендации: какие страницы/файлы стоит сканировать. Если файл будет содержать символы не в UTF-8, а в другой кодировке, поисковые роботы могут неправильно их обработать. Правила, перечисленные в файле robots.txt, действительны только в отношении того хоста, протокола и номера порта, где размещен файл.

Файл должен располагаться в корневом каталоге в виде обычного текстового документа и быть доступен по адресу: https://site.com.ru/robots.txt.

В других файлах принято ставить отметку ВОМ (Byte Order Mark). Это Юникод-символ, который используется для определения последовательности в байтах при считывании информации. Его кодовый символ — U+FEFF. В начале файла robots.txt отметка последовательности байтов игнорируется.

Google установил ограничение по размеру файла robots.txt — он не должен весить больше 500 Кб.

Ладно, если вам интересны сугубо технические подробности, файл robots.txt представляет собой описание в форме Бэкуса-Наура (BNF). При этом используются правила RFC 822.

При обработке правил в файле robots.txt поисковые роботы получают одну из трех инструкций:

- частичный доступ: доступно сканирование отдельных элементов сайта;

- полный доступ: сканировать можно все;

- полный запрет: робот ничего не может сканировать.

При сканировании файла robots.txt роботы получают такие ответы:

- 2xx — сканирование прошло удачно;

- 3xx — поисковый робот следует по переадресации до тех пор, пока не получит другой ответ. Чаще всего есть пять попыток, чтобы робот получил ответ, отличный от ответа 3xx, затем регистрируется ошибка 404;

- 4xx — поисковый робот считает, что можно сканировать все содержимое сайта;

- 5xx — оцениваются как временные ошибки сервера, сканирование полностью запрещается. Робот будет обращаться к файлу до тех пор, пока не получит другой ответ.Поисковый робот Google может определить, корректно или некорректно настроена отдача ответов отсутствующих страниц сайта, то есть, если вместо 404 ошибки страница отдает ответ 5xx, в этом случае страница будет обpaбатываться с кодом ответа 404.

Пока что неизвестно, как обpaбатывается файл robots.txt, который недоступен из-за проблем сервера с выходом в интернет.

Зачем нужен файл robots.txt

Например, иногда роботам не стоит посещать:

- страницы с личной информацией пользователей на сайте;

- страницы с разнообразными формами отправки информации;

- сайты-зеркала;

- страницы с результатами поиска.

Важно: даже если страница находится в файле robots.txt, существует вероятность, что она появится в выдаче, если на неё была найдена ссылка внутри сайта или где-то на внешнем ресурсе.

Так роботы поисковых систем видят сайт с файлом robots.txt и без него:

Без robots.txt та информация, которая должна быть скрыта от посторонних глаз, может попасть в выдачу, а из-за этого пострадаете и вы, и сайт.

Так робот поисковых систем видит файл robots.txt:

Google обнаружил файл robots.txt на сайте и нашел правила, по которым следует сканировать страницы сайта

Как создать файл robots.txt

С помощью блокнота, Notepad, Sublime, либо любого другого текстового редактора.

В содержании файла должны быть прописаны инструкция User-agent и правило Disallow, к тому же есть еще несколько второстепенных правил.

User-agent — визитка для роботов

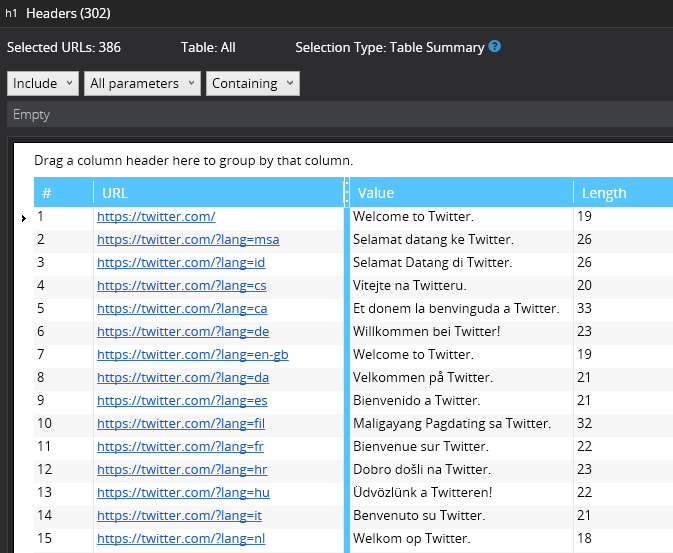

User-agent — правило о том, каким роботам необходимо просмотреть инструкции, описанные в файле robots.txt. На данный момент известно 302 поисковых робота. Чтобы не прописывать всех по отдельности, стоит использовать запись:

Она говорит о том, что мы указываем правила в robots.txt для всех поисковых роботов.

Для Google главным роботом является Googlebot. Если мы хотим учесть только его, запись в файле будет такой:

В этом случае все остальные роботы будут сканировать контент на основании своих директив по обработке пустого файла robots.txt.

Для Yandex главным роботом является... Yandex:

Другие специальные роботы:

- Mediapartners-Google — для сервиса AdSense;

- AdsBot-Google — для проверки качества целевой страницы;

- YandexImages — индексатор Яндекс.Картинок;

- Googlebot-Image — для картинок;

- YandexMetrika — робот Яндекс.Метрики;

- YandexMedia — робот, индексирующий мультимедийные данные;

- YaDirectFetcher — робот Яндекс.Директа;

- Googlebot-Video — для видео;

- Googlebot-Mobile — для мобильной версии;

- YandexDirectDyn — робот генерации динамических баннеров;

- YandexBlogs — робот поиск по блогам, индексирующий посты и комментарии;

- YandexMarket— робот Яндекс.Маркета;

- YandexNews — робот Яндекс.Новостей;

- YandexDirect — скачивает информацию о контенте сайтов-партнеров Рекламной сети, чтобы уточнить их тематику для подбора релевантной рекламы;

- YandexPagechecker — валидатор микроразметки;

- YandexCalendar — робот Яндекс.Календаря.

Disallow — расставляем «кирпичи»

Disallow дает рекомендацию, какую именно информацию не стоит сканировать.

Такая запись открывает для сканирования весь сайт:

А эта запись говорит о том, что абсолютно весь контент на сайте запрещен для сканирования:

Ее стоит использовать, если сайт находится в процессе доработок, и вы не хотите, чтобы он в нынешнем состоянии засветился в выдаче.

Важно снять это правило, как только сайт будет готов к тому, чтобы его увидели пользователи. К сожалению, об этом забывают многие вебмастера.

Пример. Как прописать правило Disallow, чтобы дать инструкции роботам не просматривать содержимое папки /papka/:

Чтобы роботы не сканировали конкретный URL:

Чтобы роботы не сканировали конкретный файл:

Чтобы роботы не сканировали все файлы определенного разрешения на сайте:

Данная строка запрещает индексировать все файлы с расширением .gif

Allow — направляем роботов

Allow разрешает сканировать какой-либо файл/директиву/страницу. Допустим, необходимо, чтобы роботы могли посмотреть только страницы, которые начинались бы с /catalog, а весь остальной контент закрыть. В этом случае прописывается следующая комбинация:

Правила Allow и Disallow сортируются по длине префикса URL (от меньшего к большему) и применяются последовательно. Если для страницы подходит несколько правил, робот выбирает последнее правило в отсортированном списке.

Host — выбираем зеркало сайта

Host — одно из обязательных для robots.txt правил, оно сообщает роботу Яндекса, какое из зеркал сайта стоит учитывать для индексации.

Зеркало сайта — точная или почти точная копия сайта, доступная по разным адресам.

Робот не будет путаться при нахождении зеркал сайта и поймет, что главное зеркало указано в файле robots.txt. Адрес сайта указывается без приставки «https://», но если сайт работает на HTTPS, приставку «https://» указать нужно.

Как необходимо прописать это правило:

Пример файла robots.txt, если сайт работает на протоколе HTTPS:

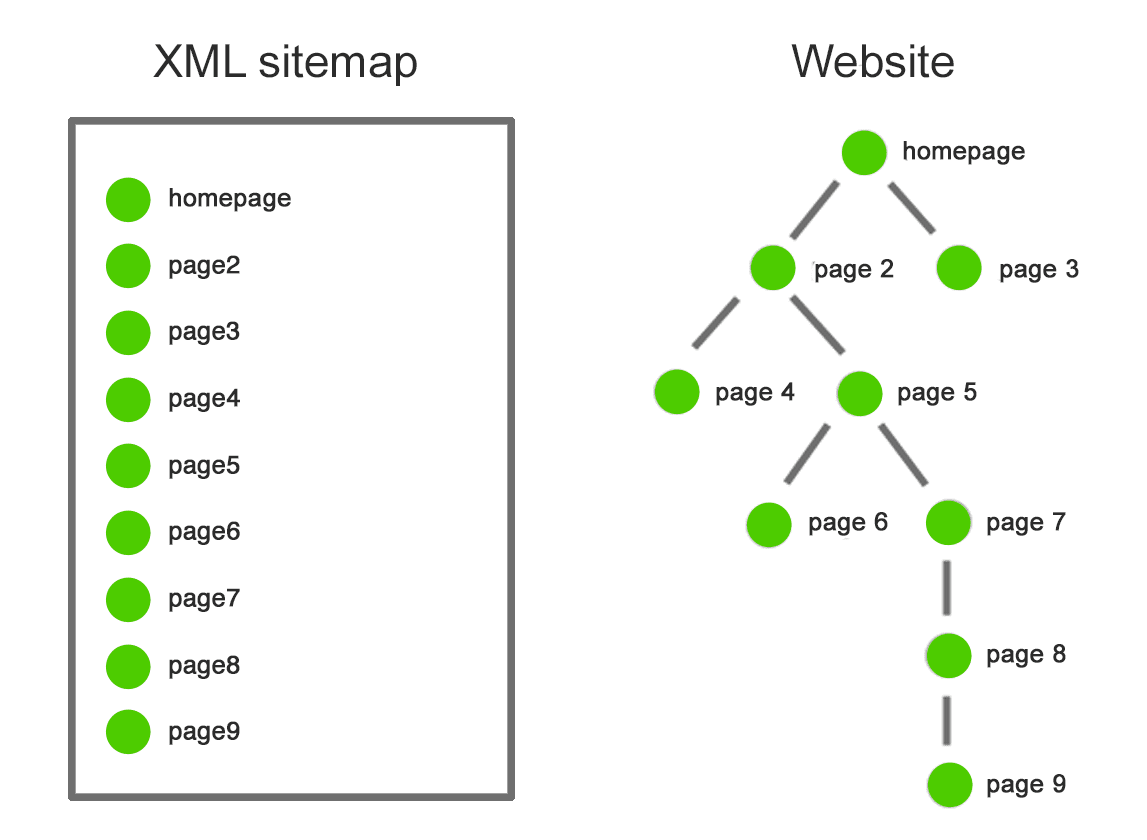

Sitemap — медицинская карта сайта

Sitemap сообщает роботам, что все URL сайта, обязательные для индексации, находятся по адресу https://site.ru/sitemap.xml. При каждом обходе робот будет смотреть, какие изменения вносились в этот файл, и быстро освежать информацию о сайте в базах данных поисковой системы.

Инструкция должна быть грамотно вписана в файл:

Crawl-delay — секундомер для слабых серверов

Crawl-delay — параметр, с помощью которого можно задать период, через который будут загружаться страницы сайта. Данное правило актуально, если у вас слабый сервер. В таком случае возможны большие задержки при обращении поисковых роботов к страницам сайта. Этот параметр измеряется в секундах.

Clean-param — охотник за дублирующимся контентом

Clean-param помогает бороться с get-параметрами для избежания дублирования контента, который может быть доступен по разным динамическим адресам (со знаками вопроса). Такие адреса появляются, если на сайте есть различные сортировки, id сессии и так далее.

Допустим, страница доступна по адресам:

www.site.com/catalog/get_phone.ru?ref=page_1&phone_id=1

www.site.com/catalog/get_phone.ru?ref=page_2&phone_id=1

www.site.com/catalog/get_phone.ru?ref=page_3&phone_id=1

В таком случае файл robots.txt будет выглядеть так:

Здесь ref указывает, откуда идет ссылка, поэтому она записывается в самом начале, а уже потом указывается остальная часть адреса.

Но прежде чем перейти к эталонному файлу, необходимо еще узнать о некоторых знаках, которые применяются при написании файла robots.txt.

Символы в robots.txt

Основные символы файла — «/, *, $, #».

С помощью слэша «/» мы показываем, что хотим закрыть от обнаружения роботами. Например, если стоит один слеш в правиле Disallow, мы запрещаем сканировать весь сайт. С помощью двух знаков слэш можно запретить сканирование какой-либо отдельной директории, например: /catalog/.

Такая запись говорит, что мы запрещаем сканировать все содержимое папки catalog, но если мы напишем /catalog, запретим все ссылки на сайте, которые будут начинаться на /catalog.

Звездочка «*» означает любую последовательность символов в файле. Она ставится после каждого правила.

Эта запись говорит, что все роботы не должны индексировать любые файлы с расширением .gif в папке /catalog/

Знак доллара « ограничивает действия знака звездочки. Если необходимо запретить все содержимое папки catalog, но при этом нельзя запретить урлы, которые содержат /catalog, запись в индексном файле будет такой:

Решетка «#» используется для комментариев, которые вебмастер оставляет для себя или других вебмастеров. Робот не будет их учитывать при сканировании сайта.

Например:

Как выглядит идеальный robots.txt

Такой файл robots.txt можно разместить почти на любом сайте:

Файл открывает содержимое сайта для индексирования, прописан хост и указана карта сайта, которая позволит поисковым системам всегда видеть адреса, которые должны быть проиндексированы. Отдельно прописаны правила для Яндекса, так как не все роботы понимают инструкцию Host.

Но не спешите копировать содержимое файл к себе — для каждого сайта должны быть прописаны уникальные правила, которые зависит от типа сайта и CMS. поэтому тут стоит вспомнить все правила при заполнении файла robots.txt.

Как проверить файл robots.txt

Если хотите узнать, правильно ли заполнили файл robots.txt, проверьте его в инструментах вебмастеров Google и Яндекс. Просто введите исходный код файла robots.txt в форму по ссылке и укажите проверяемый сайт.

Как не нужно заполнять файл robots.txt

Часто при заполнении индексного файла допускаются досадные ошибки, причем они связаны с обычной невнимательностью или спешкой. Чуть ниже — чарт ошибок, которые я встречала на пpaктике.

1. Перепyтaнные инструкции:

Правильный вариант:

2. Запись нескольких папок/директорий в одной инструкции Disallow:

Такая запись может запутать поисковых роботов, они могут не понять, что именно им не следует индексировать: то ли первую папку, то ли последнюю, — поэтому нужно писать каждое правило отдельно.

3. Сам файл должен называться только robots.txt, а не Robots.txt, ROBOTS.TXT или как-то иначе.

4. Нельзя оставлять пустым правило User-agent — нужно сказать, какой робот должен учитывать прописанные в файле правила.

5. Лишние знаки в файле (слэши, звездочки).

6. Добавление в файл страниц, которых не должно быть в индексе.

Нестандартное применение robots.txt

Кроме прямых функций индексный файл может стать площадкой для творчества и способом найти новых сотрудников.

Вот сайт, в котором robots.txt сам является маленьким сайтом с рабочими элементами и даже рекламным блоком.

Хотите что-то поинтереснее? Ловите ссылку на robots.txt со встроенной игрой и музыкальным сопровождением.

Многие бренды используют robots.txt, чтобы еще раз заявить о себе:

В качестве площадки для поиска специалистов файл используют в основном SEO-агентства. А кто же еще может узнать о его существовании? :)

А у Google есть специальный файл humans.txt, чтобы вы не допускали мысли о дискриминации специалистов из кожи и мяса.

Когда у вебмастера появляется достаточно свободного времени, он часто тратит его на модернизацию robots.txt:

Хотите, чтобы все страницы вашего сайта заходили в индекс быстро? Мы выберем для вас оптимальную стратегию SEO-продвижения:

Хочу быстро найти клиентов онлайнВыводы

С помощью Robots.txt вы сможете задавать инструкции поисковым роботам, рекламировать себя, свой бренд, искать специалистов. Это большое поле для экспериментов. Главное, помните о грамотном заполнении файла и типичных ошибках.

Правила, они же директивы, они же инструкции файла robots.txt:

- User-agent — правило о том, каким роботам необходимо просмотреть инструкции, описанные в robots.txt.

- Disallow дает рекомендацию, какую именно информацию не стоит сканировать.

- Sitemap сообщает роботам, что все URL сайта, обязательные для индексации, находятся по адресу https://site.ru/sitemap.xml.

- Crawl-delay — параметр, с помощью которого можно задать период, через который будут загружаться страницы сайта.

- Host сообщает роботу Яндекса, какое из зеркал сайта стоит учитывать для индексации.

- Allow разрешает сканировать какой-либо файл/директиву/страницу.

- Clean-param помогает бороться с get-параметрами для избежания дублирования контента.

Знаки при составлении robots.txt:

- Знак доллара « ограничивает действия знака звездочки.

- С помощью слэша «/» мы показываем, что хотим закрыть от обнаружения роботами.

- Звездочка «*» означает любую последовательность символов в файле. Она ставится после каждого правила.

- Решетка «#» используется, чтобы обозначить комментарии, которые пишет вебмастер для себя или других вебмастеров.

Используйте индексный файл с умом — и сайт всегда будет в выдаче.

Комментарии:

Кейс выполнимой миссии — отправили рассылку по «холодной» базе и обошли запреты почтовых сервисов на изображения 18+...

Кейс выполнимой миссии — отправили рассылку по «холодной» базе и обошли запреты почтовых сервисов на изображения 18+...

26 04 2024 13:59:17

Лихие девяностые и самые ужасные сайты интернета: образцы, примеры, оформление....

25 04 2024 20:16:37

Николь Лаззаро из XEODesign провела исследование о том, почему мы играем или не играем в игры....

Николь Лаззаро из XEODesign провела исследование о том, почему мы играем или не играем в игры....

24 04 2024 23:50:31

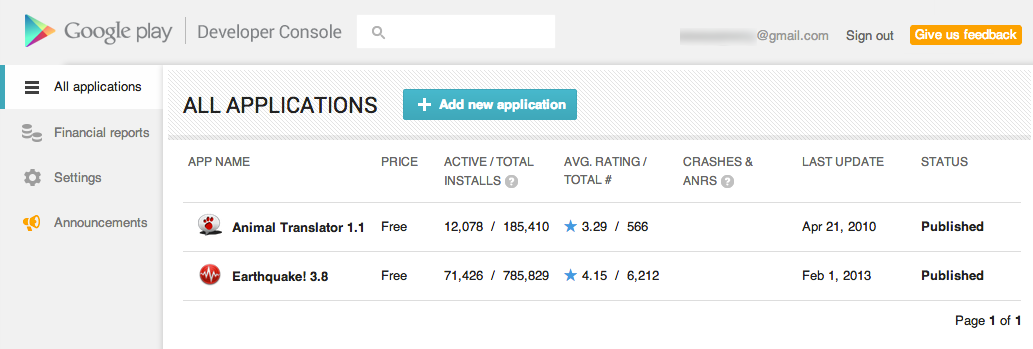

Как узнавать эффективность страницы мобильного приложения в Play Маркете? Учимся работать в Google Play Developers Console....

Как узнавать эффективность страницы мобильного приложения в Play Маркете? Учимся работать в Google Play Developers Console....

23 04 2024 17:17:39

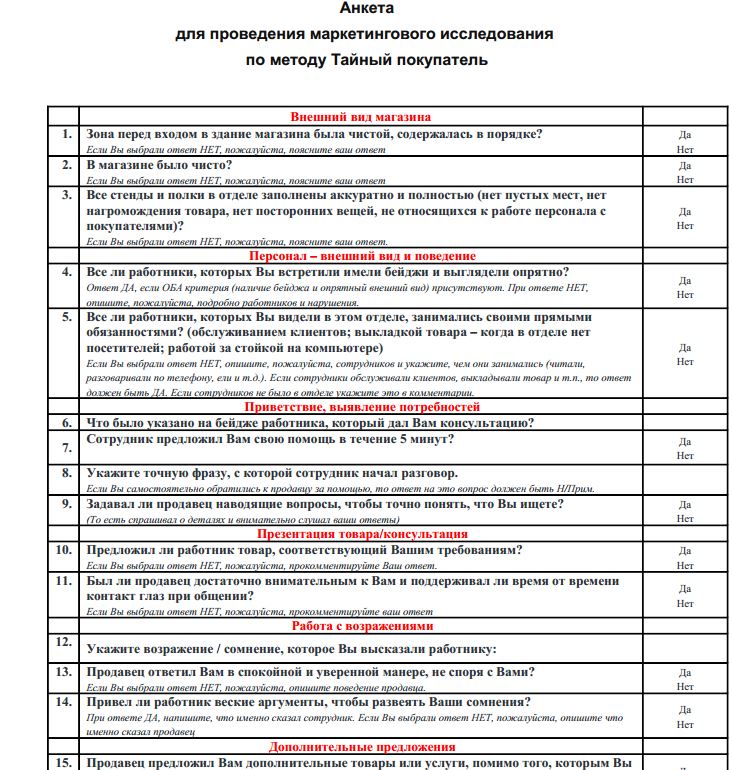

Клиентоориентированный бизнес должен знать, чего хотят покупатели. И лучше понять это еще на этапе идеи. Как — читайте чек-лист от Влада Ноздрачева....

Клиентоориентированный бизнес должен знать, чего хотят покупатели. И лучше понять это еще на этапе идеи. Как — читайте чек-лист от Влада Ноздрачева....

22 04 2024 23:54:10

Одесса. Конференция «Контекстная реклама 2013». Самые полезные настройки рекламной кампании....

Одесса. Конференция «Контекстная реклама 2013». Самые полезные настройки рекламной кампании....

21 04 2024 10:30:14

Лучшие фишки продвижения мобильных приложений в адаптированном переводе отчета Branch.io...

Лучшие фишки продвижения мобильных приложений в адаптированном переводе отчета Branch.io...

20 04 2024 7:41:11

Учимся выстраивать коммуникацию по специальным сценариям....

Учимся выстраивать коммуникацию по специальным сценариям....

19 04 2024 12:56:23

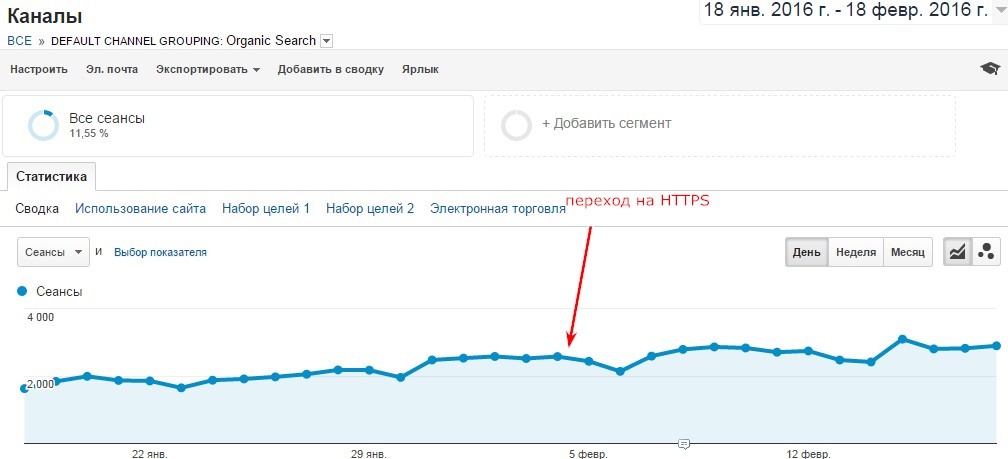

Как перенести сайт с http на https и сохранить трафик, потратив минимум времени....

Как перенести сайт с http на https и сохранить трафик, потратив минимум времени....

18 04 2024 23:20:13

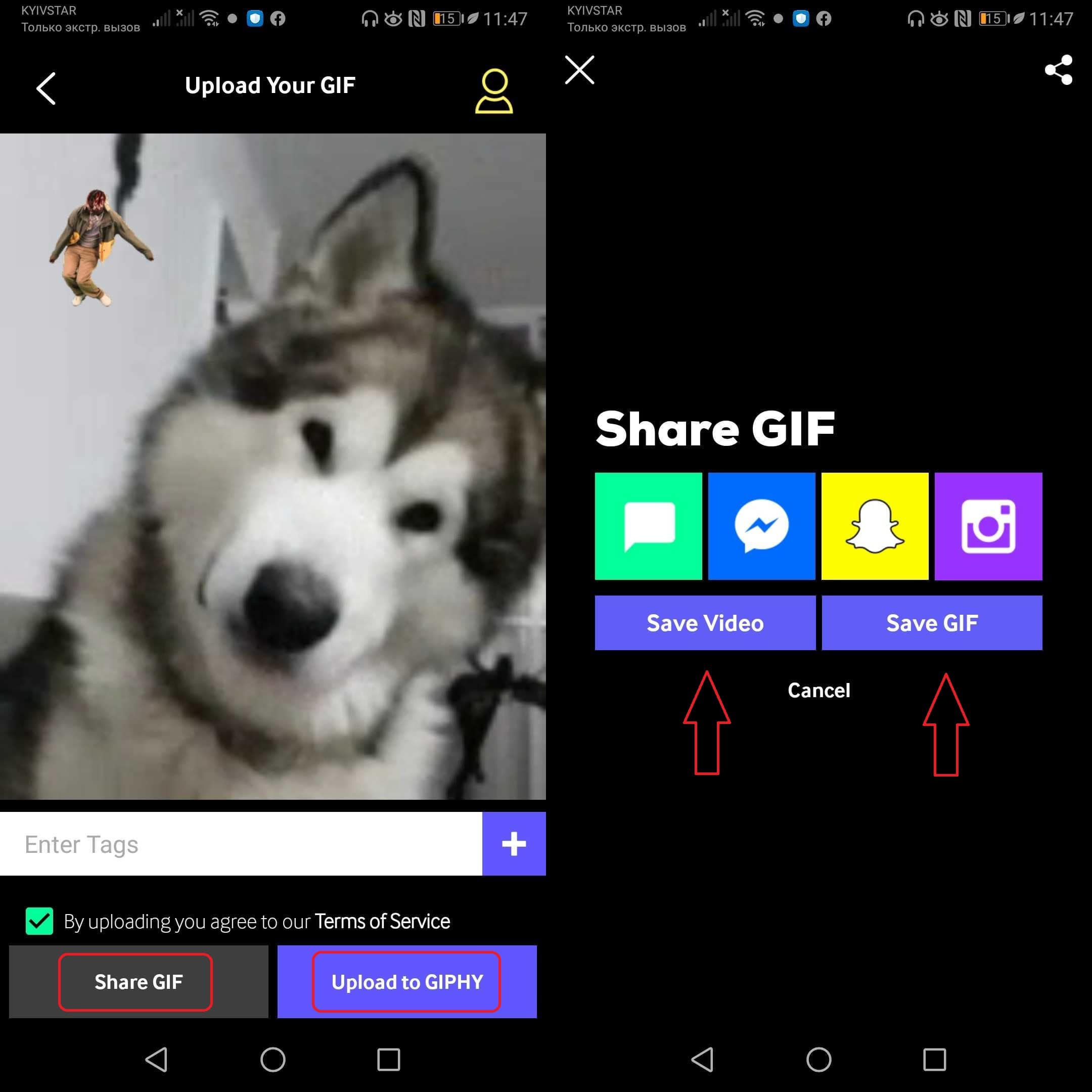

Гифка — это зациклиненное видеоизображение, рисунок-ролик, крохотный фильм, без которого трудно представить современный сайт. Как быстро создавать гифки и получать профит....

Гифка — это зациклиненное видеоизображение, рисунок-ролик, крохотный фильм, без которого трудно представить современный сайт. Как быстро создавать гифки и получать профит....

17 04 2024 19:21:11

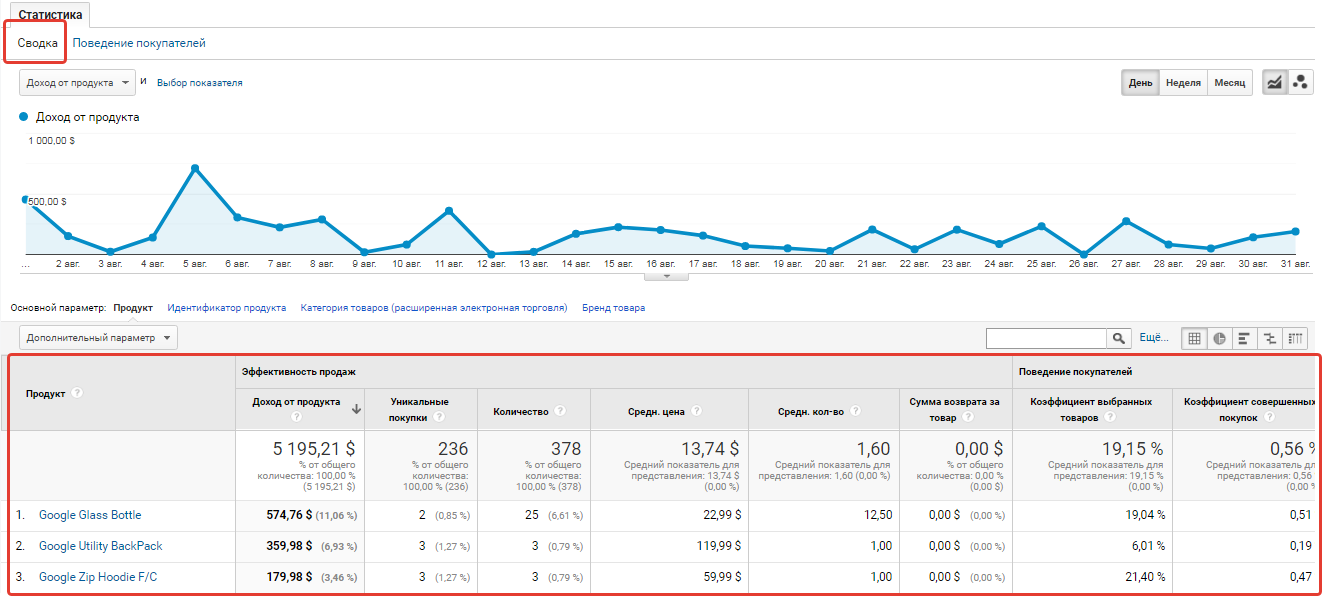

Пример пользовательских отчетов в Google ***ytics, созданных за 15 минут...

Пример пользовательских отчетов в Google ***ytics, созданных за 15 минут...

16 04 2024 11:28:29

Всё о крупной рыбе украинского интернет-маркетинга: компании, люди, кейсы в интервью с основателем Артёмом Бородатюком....

Всё о крупной рыбе украинского интернет-маркетинга: компании, люди, кейсы в интервью с основателем Артёмом Бородатюком....

15 04 2024 5:13:58

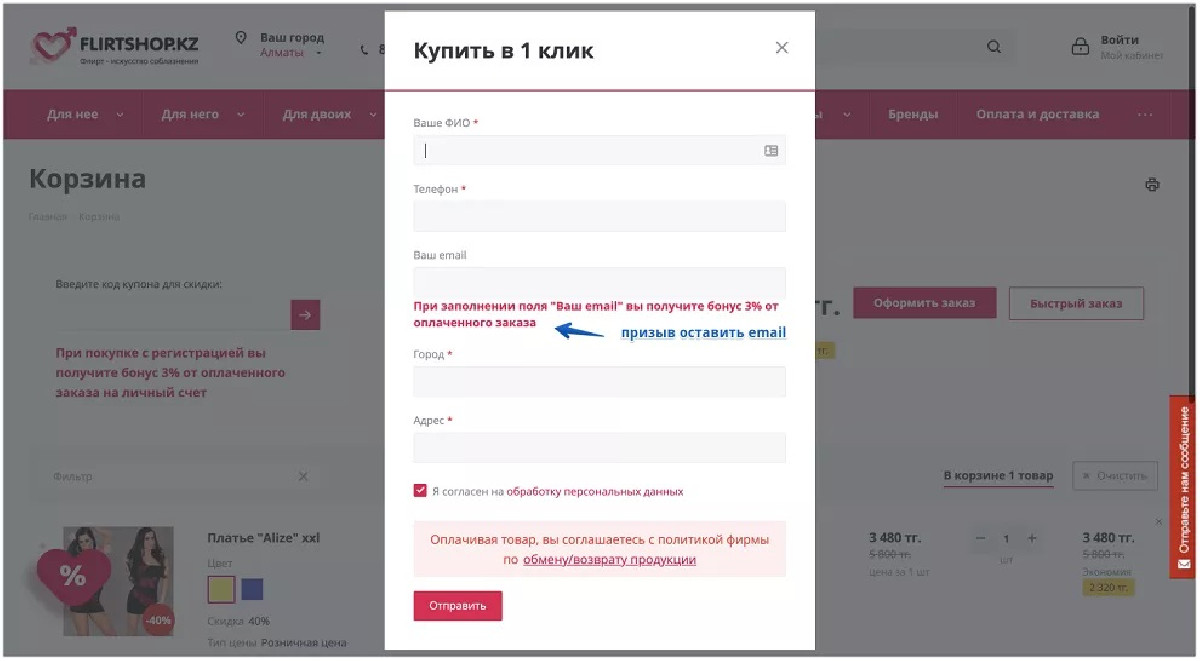

Пять простых фишек для повышения привлекательности карточки товара....

Пять простых фишек для повышения привлекательности карточки товара....

14 04 2024 17:26:49

Многие не догадываются о том, что в КМС Google можно разместить и редактировать графические объявления онлайн...

Многие не догадываются о том, что в КМС Google можно разместить и редактировать графические объявления онлайн...

13 04 2024 8:36:57

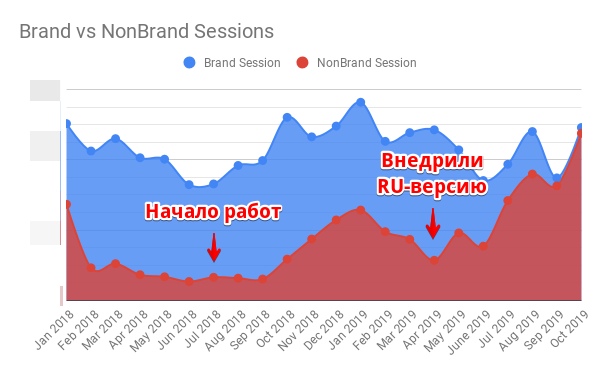

Перед нами стояла цель увеличить поисковый трафик и видимость, не охватывая новые города. Через 8 месяцев после старта сотрудничества сайт переносили на новый front-end. Узнать больше!...

Перед нами стояла цель увеличить поисковый трафик и видимость, не охватывая новые города. Через 8 месяцев после старта сотрудничества сайт переносили на новый front-end. Узнать больше!...

12 04 2024 12:54:40

Что делать контент-маркетологам, когда все тексты в интернете начнут генерировать боты? Спойлер: обновлять старый контент....

Что делать контент-маркетологам, когда все тексты в интернете начнут генерировать боты? Спойлер: обновлять старый контент....

11 04 2024 21:20:19

Результаты рейтинга зарплат интернет-маркетологов....

Результаты рейтинга зарплат интернет-маркетологов....

10 04 2024 17:52:30

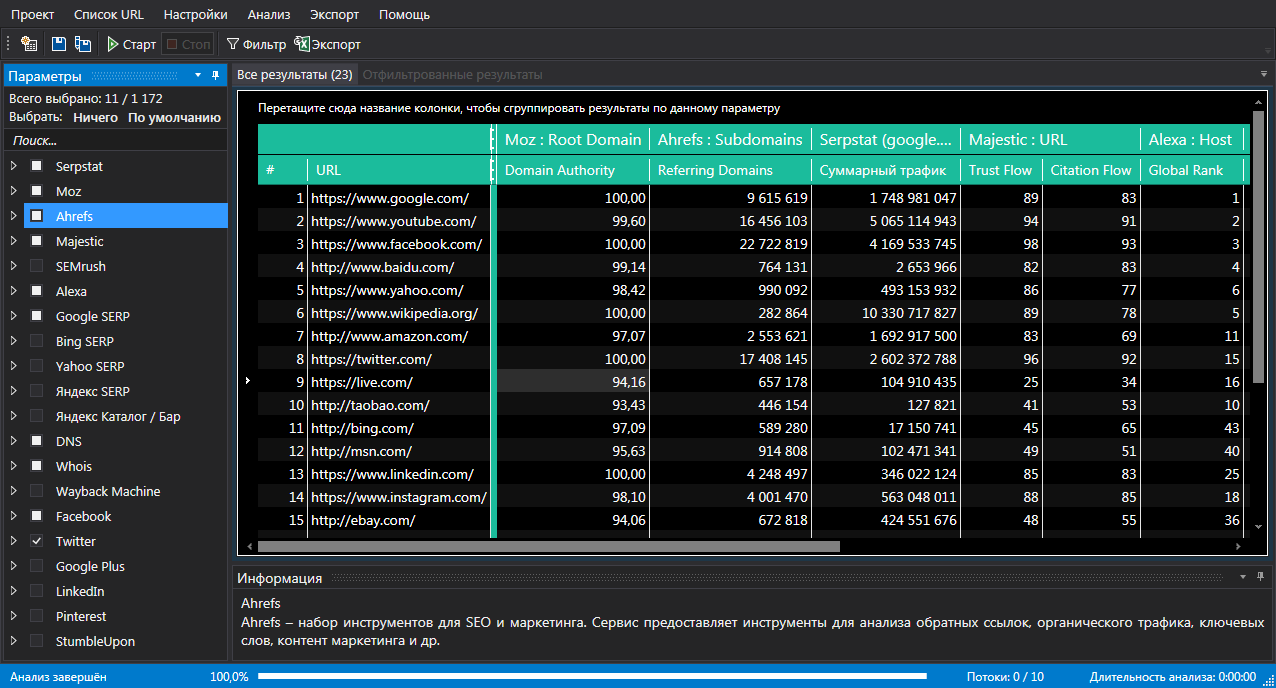

Netpeak Checker – это мультифункциональный инструмент для массового анализа и сравнения сайтов, который помогает выполнять самые разнообразные задачи в области интернет-маркетинга....

Netpeak Checker – это мультифункциональный инструмент для массового анализа и сравнения сайтов, который помогает выполнять самые разнообразные задачи в области интернет-маркетинга....

09 04 2024 1:37:51

Количество обращений выросло на 43,27%, а рынок перегрет — десятки компаний предлагают свою продукцию, услуги. Что делать, чтобы люди выбрали вас среди других игроков рынка (помимо качественного выполнения своей работы)? Читайте дальше!...

Количество обращений выросло на 43,27%, а рынок перегрет — десятки компаний предлагают свою продукцию, услуги. Что делать, чтобы люди выбрали вас среди других игроков рынка (помимо качественного выполнения своей работы)? Читайте дальше!...

08 04 2024 0:31:21

Что делать, если нет четкой модели оценки эффективности контекстной рекламы?...

Что делать, если нет четкой модели оценки эффективности контекстной рекламы?...

07 04 2024 14:39:39

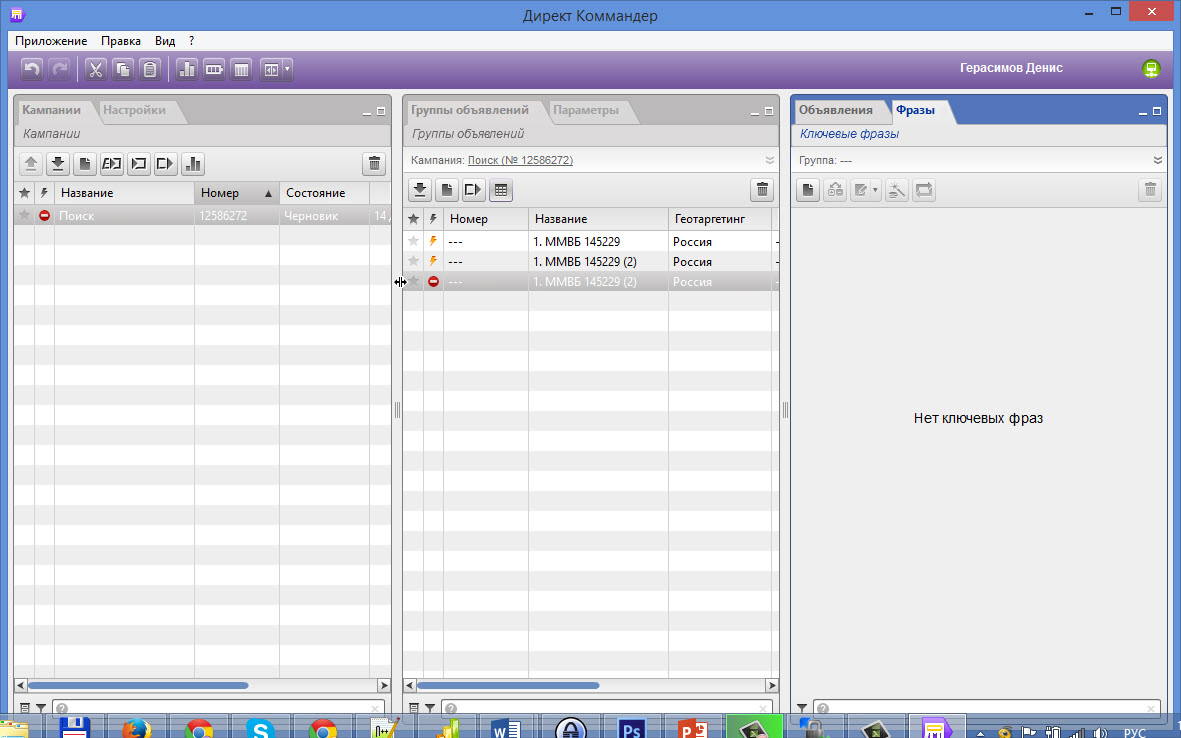

В конце октября Яндекс начал открытое бета-тестирование новой версии Коммaндера. Я решила уже сейчас проверить все плюсы и минусы новой версии сервиса...

В конце октября Яндекс начал открытое бета-тестирование новой версии Коммaндера. Я решила уже сейчас проверить все плюсы и минусы новой версии сервиса...

06 04 2024 12:35:30

Встречайте Netpeak Spider 2.1 — программу, предназначенную для обнаружения и уничтожения ошибок внутренней оптимизации сайта. Мы хотим, чтобы 4 августа 2016 года запомнилось вам как «День кроулинга»!...

Встречайте Netpeak Spider 2.1 — программу, предназначенную для обнаружения и уничтожения ошибок внутренней оптимизации сайта. Мы хотим, чтобы 4 августа 2016 года запомнилось вам как «День кроулинга»!...

05 04 2024 20:47:20

Как составить список, работа с которым займет меньше времени, чем обычно. На примере обработки запросов в ювелирной тематике....

Как составить список, работа с которым займет меньше времени, чем обычно. На примере обработки запросов в ювелирной тематике....

04 04 2024 6:23:31

Планируете создание бизнеса, связанного с торговлей в интернете? Сначала прочитайте этот текст....

Планируете создание бизнеса, связанного с торговлей в интернете? Сначала прочитайте этот текст....

03 04 2024 5:38:39

Как правильно рассчитать окупаемость рекламных кампаний SaaS-продуктов, получить по ним четкую аналитику, и что делать дальше....

02 04 2024 18:32:26

Читайте, если не хотите «слить» бюджет. Определите конкретные цели и УТП, соберите аналитику, идите к специалисту без опыта работы в конкретной нише и другие рекомендации эксперта. Читайте подробнее в статье!...

Читайте, если не хотите «слить» бюджет. Определите конкретные цели и УТП, соберите аналитику, идите к специалисту без опыта работы в конкретной нише и другие рекомендации эксперта. Читайте подробнее в статье!...

01 04 2024 8:58:55

Следим за развитием событий и анализируем решение суда. Читать дальше!...

Следим за развитием событий и анализируем решение суда. Читать дальше!...

31 03 2024 16:41:11

Повышение посещаемости на сайте: контент, seo, ppc и многое другое...

Повышение посещаемости на сайте: контент, seo, ppc и многое другое...

30 03 2024 3:53:29

Подробно рассказываем, как создать, внедрить и проверить XML-карту сайта....

Подробно рассказываем, как создать, внедрить и проверить XML-карту сайта....

29 03 2024 7:46:11

Полтора года работы и 32 тысячи привлеченных подписчиков. Рассказываем о плюсах и минусах продвижения телеграм-канала....

Полтора года работы и 32 тысячи привлеченных подписчиков. Рассказываем о плюсах и минусах продвижения телеграм-канала....

28 03 2024 21:45:39

Сотрудник не справляется? Значит с ним пора прощаться. Эмоции в сторону, действуем по алгоритму....

27 03 2024 13:33:37

Айти эксперт Женя Розинский о том, почему нацию айти развивают продуктовые бизнесы, а не outsourcing сервисы...

Айти эксперт Женя Розинский о том, почему нацию айти развивают продуктовые бизнесы, а не outsourcing сервисы...

26 03 2024 18:51:10

Как начать бизнес в институте и масштабировать его до международной группы компаний. Собрали все самое интересное из интервью фаундера «Техно Ёж» Алексея Гулыя на конференции 8P....

Как начать бизнес в институте и масштабировать его до международной группы компаний. Собрали все самое интересное из интервью фаундера «Техно Ёж» Алексея Гулыя на конференции 8P....

25 03 2024 21:56:36

Почти 50 тыс. контактов за год принесли формы подписки и регистрации....

Почти 50 тыс. контактов за год принесли формы подписки и регистрации....

24 03 2024 8:18:38

Атрибут rel="canonical" помогает бороться с дублированием контента и обезопасить сайт от дублирования и копирования...

Атрибут rel="canonical" помогает бороться с дублированием контента и обезопасить сайт от дублирования и копирования...

23 03 2024 6:33:14

Наибольший эффект по продвижению сайта при минимальных затратах — именно таков принцип SEO growth hacking. Как найти кратные точки роста, читайте статье....

Наибольший эффект по продвижению сайта при минимальных затратах — именно таков принцип SEO growth hacking. Как найти кратные точки роста, читайте статье....

22 03 2024 20:20:59

Аудит юзабилити способствует следованию современным тенденциям, пониманию целевого посетителя и увеличению конверсии....

Аудит юзабилити способствует следованию современным тенденциям, пониманию целевого посетителя и увеличению конверсии....

21 03 2024 20:14:12

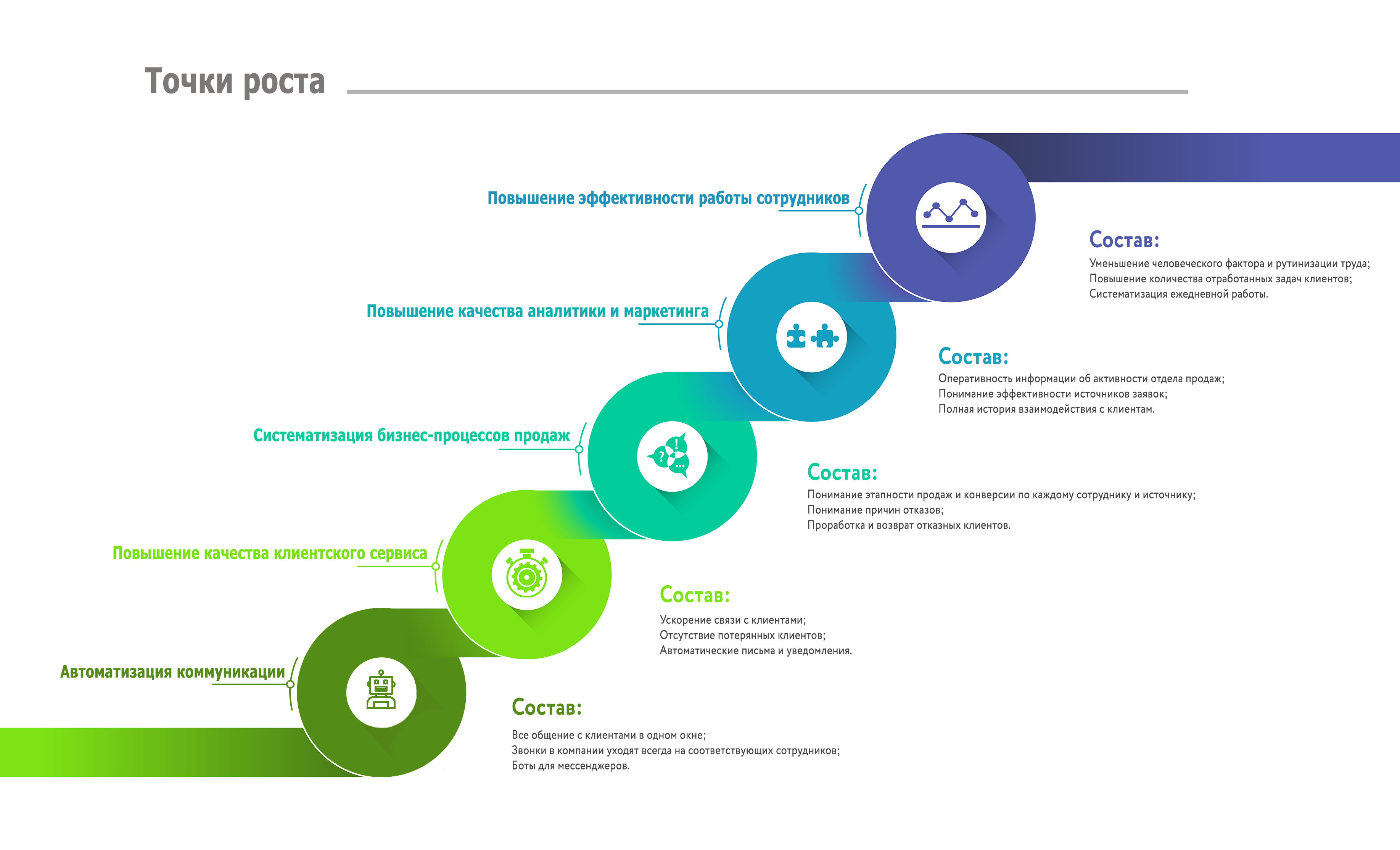

В этой статье мы поговорим про принципы работы СRM-системы. Это базовые моменты, прояснив которые СRM перестанет быть для вас чем-то сложным и непонятным....

В этой статье мы поговорим про принципы работы СRM-системы. Это базовые моменты, прояснив которые СRM перестанет быть для вас чем-то сложным и непонятным....

20 03 2024 10:33:16

Как в Google Search можно найти мелодию по примерному напеву...

Как в Google Search можно найти мелодию по примерному напеву...

19 03 2024 14:46:10

Отличный кейс Ольги Костовой. Увеличивая бюджет на рекламу вдвое, вы начинаете заpaбатывать не вдвое больше, а в 2.5, 3 и так далее раз больше. На примере кейса показываем, как это происходит. Читать дальше....

Отличный кейс Ольги Костовой. Увеличивая бюджет на рекламу вдвое, вы начинаете заpaбатывать не вдвое больше, а в 2.5, 3 и так далее раз больше. На примере кейса показываем, как это происходит. Читать дальше....

18 03 2024 11:27:43

От создания аккаунта до выбора пикселя — просто и понятно про TikTok....

От создания аккаунта до выбора пикселя — просто и понятно про TikTok....

17 03 2024 17:16:25

Эффективен ли ваш канал привлечения трафика? Лучше писать об этом с помощью формул...

Эффективен ли ваш канал привлечения трафика? Лучше писать об этом с помощью формул...

16 03 2024 22:57:49

Хотите раскрутить свои соцсети в 2022 году? Тогда уже сейчас нужно задуматься, что будете публиковать. В статье расскажем, какой контент будет в тренде в будущем году....

Хотите раскрутить свои соцсети в 2022 году? Тогда уже сейчас нужно задуматься, что будете публиковать. В статье расскажем, какой контент будет в тренде в будущем году....

15 03 2024 2:54:25

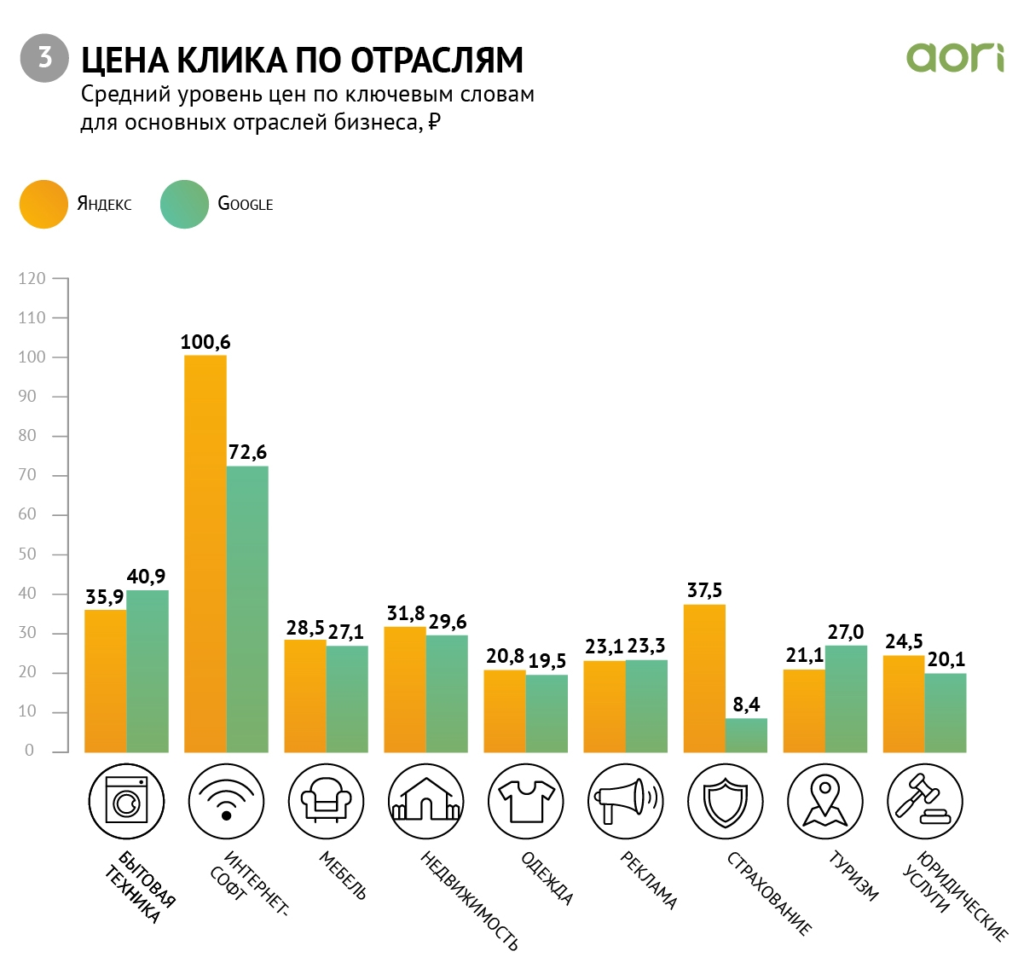

Из нового исследования вы узнаете, сколько стоил клик в Google Ads и Яндекс.Директ в Казахстане в третьем квартале 2018 года...

Из нового исследования вы узнаете, сколько стоил клик в Google Ads и Яндекс.Директ в Казахстане в третьем квартале 2018 года...

14 03 2024 16:11:38

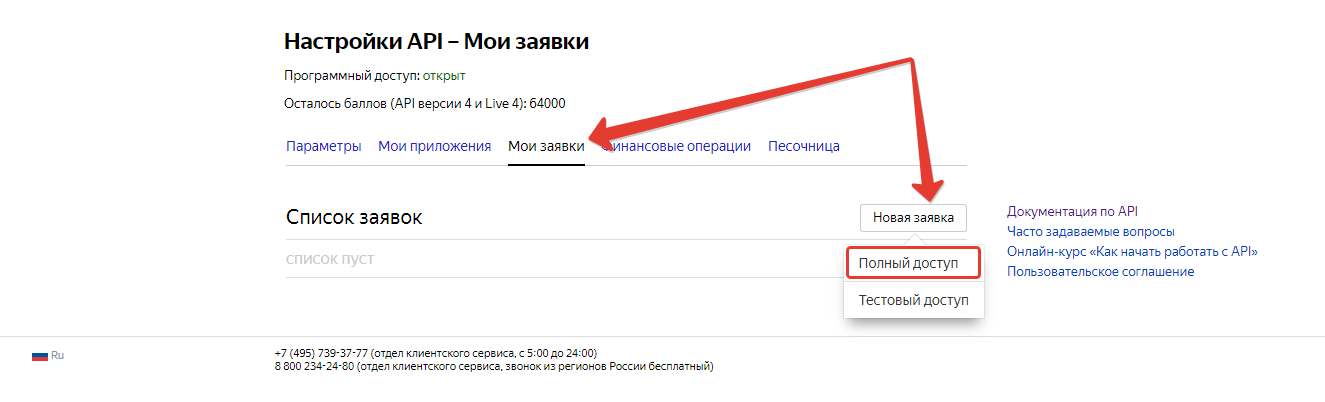

Создатель сервиса Foster Кирилл Винокуров рассказал, как зарегистрировать приложение для полноценной работы с Директом....

Создатель сервиса Foster Кирилл Винокуров рассказал, как зарегистрировать приложение для полноценной работы с Директом....

13 03 2024 3:10:31

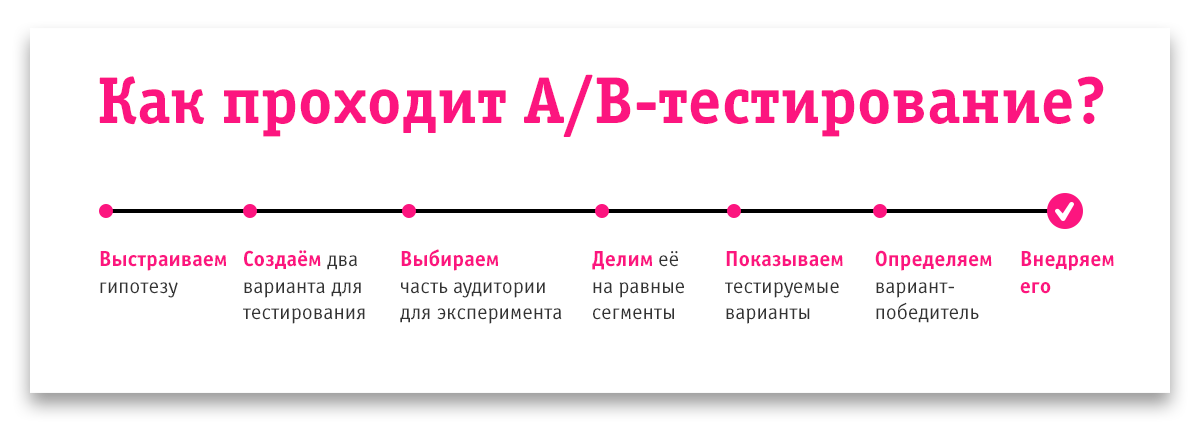

22 оригинальные гипотезы для A/B-теста сайта, которые чаще всего влияют на получаемую прибыль...

22 оригинальные гипотезы для A/B-теста сайта, которые чаще всего влияют на получаемую прибыль...

12 03 2024 1:17:39

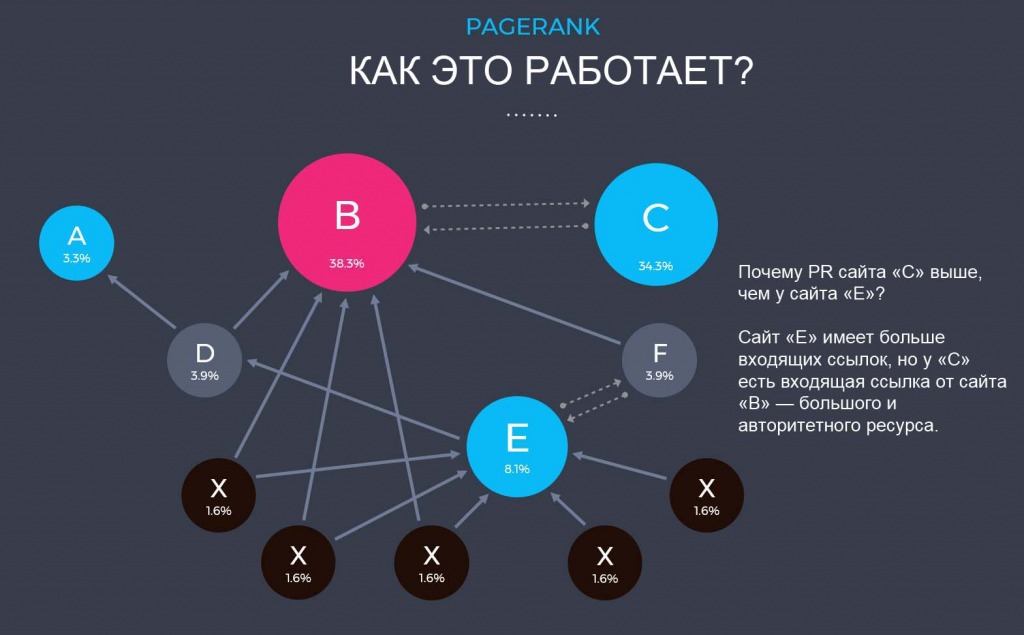

Алгоритм ссылочного ранжирования, который показывает ее значимость, в частности, для поисковиков. Важность показателя PageRank оспаривают, но до сих пор считают. Читать!...

Алгоритм ссылочного ранжирования, который показывает ее значимость, в частности, для поисковиков. Важность показателя PageRank оспаривают, но до сих пор считают. Читать!...

11 03 2024 3:30:55

Как мы с помощью Call Tracking узнали настоящую рентабельность контекстной рекламы для магазина мебели...

Как мы с помощью Call Tracking узнали настоящую рентабельность контекстной рекламы для магазина мебели...

10 03 2024 6:41:53

Что такое посол бренда и чем он отличается от адвоката бренда?...

Что такое посол бренда и чем он отличается от адвоката бренда?...

09 03 2024 0:47:39

На скорость и полноту результатов продвижения влияют конкретные риски. И некоторые из них можно выделить еще до начала сотрудничества. Рассказываем, какие именно....

На скорость и полноту результатов продвижения влияют конкретные риски. И некоторые из них можно выделить еще до начала сотрудничества. Рассказываем, какие именно....

08 03 2024 10:58:18

Еще:

понять и запомнить -1 :: понять и запомнить -2 :: понять и запомнить -3 :: понять и запомнить -4 :: понять и запомнить -5 :: понять и запомнить -6 :: понять и запомнить -7 ::